2026. 3. 4. 21:44 투자

'분류 전체보기'에 해당되는 글 1068건

- 2026.03.04 검은 수요일이 왔다.

- 2026.02.12 Oracle 26ai RAC 설치

- 2026.01.25 26ai 설치

- 2026.01.21 패치작업 19.30.0.0.260120 (GI RU 38629535 )

- 2026.01.10 일론 머스크 팟캐스트 발언 30개 요약

- 2025.12.24 Oracle MOS 사이트 개편 1

- 2025.12.09 Oracle 26ai Desupport Features

- 2025.12.09 Oracle AI 26ai Linux x86-64 on-premise 버전 출시예정!!

- 2025.12.03 그녀를 지키다 - 장 밥티스트 안드레아

- 2025.11.28 23ai Hidden parameter 확인 (23.7 버전 기준)

2026. 2. 12. 13:18 오라클

Oracle 26ai RAC 설치

미루고 있던 Oracle 26ai RAC 설치/구성을 해 보았다.

작업 과정 자체는 19c 와 크게 달라진 것은 없고 느끼는 점은 굉장히 무거워졌다.

노트북 메모리 32G인데 Virtualbox 내에서 돌리기가 굉장히 버겁다..노트북이 살려줘하는 느낌..

Multitenant 구조라 database 생성하는데 6시간 걸림..샤갈...

=============================================

설치환경 : REHL 9.7

Oracle 23.26.1.0.0

- Directory 사전 생성

mkdir -p /u01/app/oracle

mkdir -p /u01/app/26.0.0.0/grid

mkdir -p /u01/app/oracle/product/26.0.0.0/dbhome_1

chown -R oracle:dba /u01

- Oracle Grid Infrastructure S/W설치

1. 설치파일을 FTP로 해당서버에upload

LINUX.X64_2326100_grid_home.zip <-- 설치 Image 파일

p6880880_230000_Linux-x86-64.zip <-- OPatch 파일

2. 설치이미지 압축해제 (반드시 $GI_HOME 밑에 압축해제 해야 함)

unzip LINUX.X64_2326100_grid_home.zip -d $GI_HOME

unzip p6880880_230000_Linux-x86-64.zip -d $GI_HOME

3. gridSetup.sh실행

xhost +

su – oracle

export DISPLAY=작업PC IP:0.0

cd $GI_HOME

./ gridSetup.sh 실행

[Configure Oracle Grid Infrastructure for a New Cluster 선택후, Next]

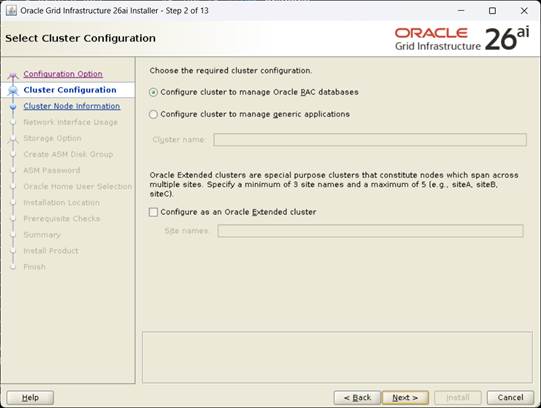

[Configure Clusterto manage Oracle RAC databases, Next]

[Cluster Name, SCAN Name 지정후, Next]

[add 버튼으로 rac2노드 추가 후 passwordless ssh , Next]

[Network Interface 지정 후, Next]

[Use Oracle Flex ASM for storage 선택 후, Next]

[VOTE 디스크 지정 후, Next] 여기서는 Normal로 구성함

[비밀번호 지정 후, Next]

[Enable Automatic Self Correction uncheck, Next]

[Do not use IPMI , Next]

[EM 미구성, Next]

[dba 그룹지정후, Next]

[GI Base 지정 후, Next]

[Inventory 지정후, Next]

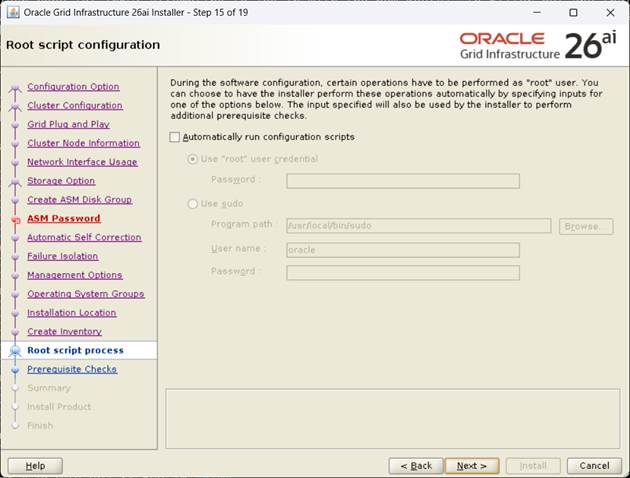

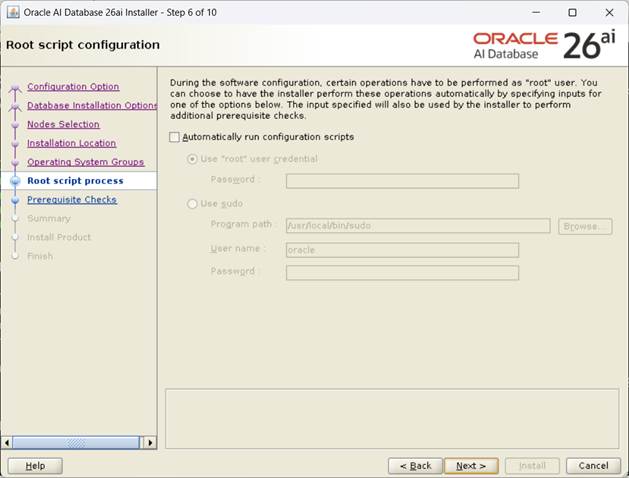

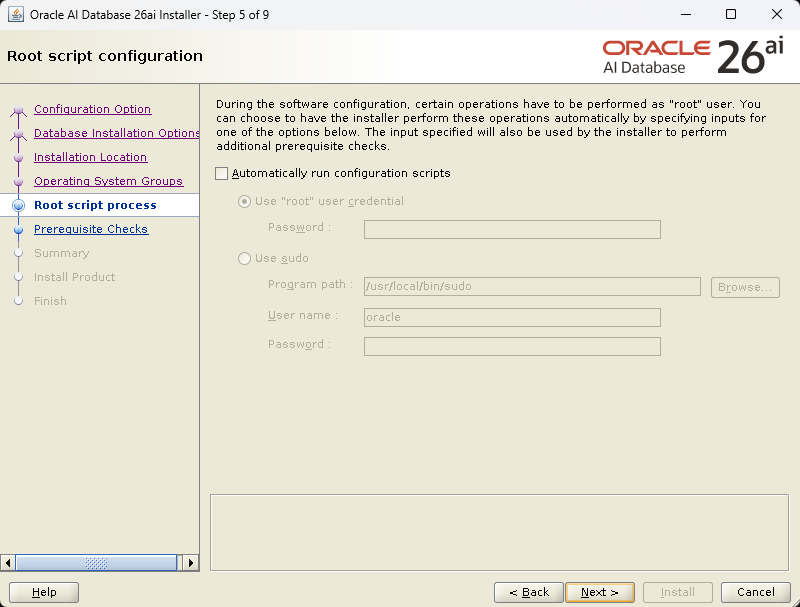

[자동 스크립트 uncheck후, Next]

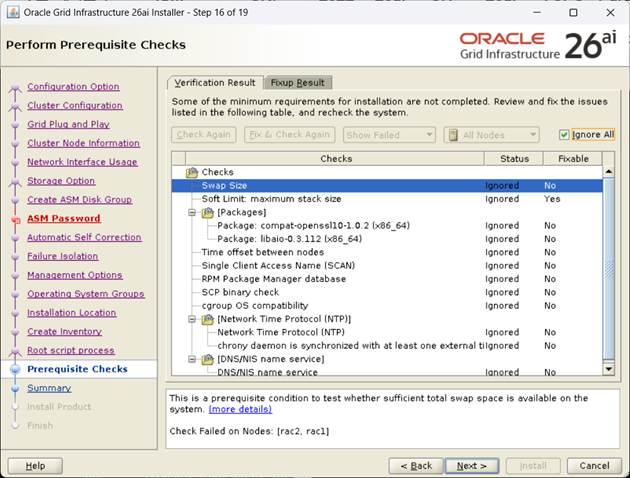

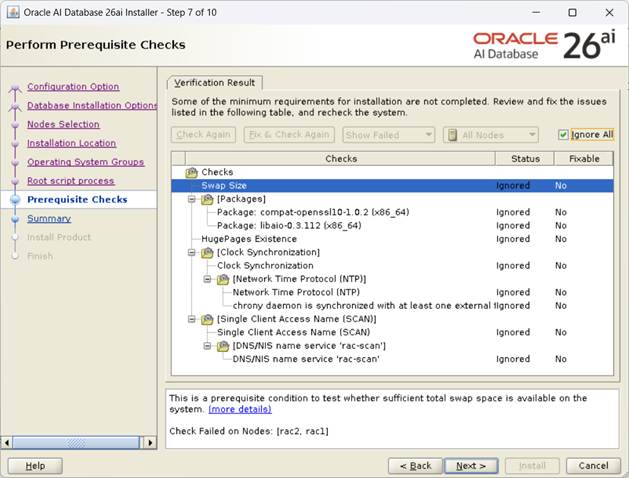

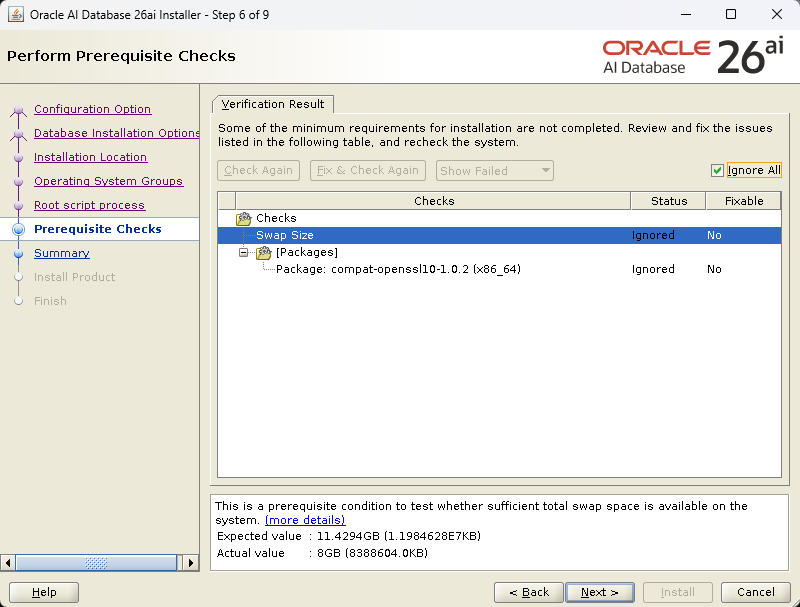

[Fixup 후 Ignore All check 후, Next]

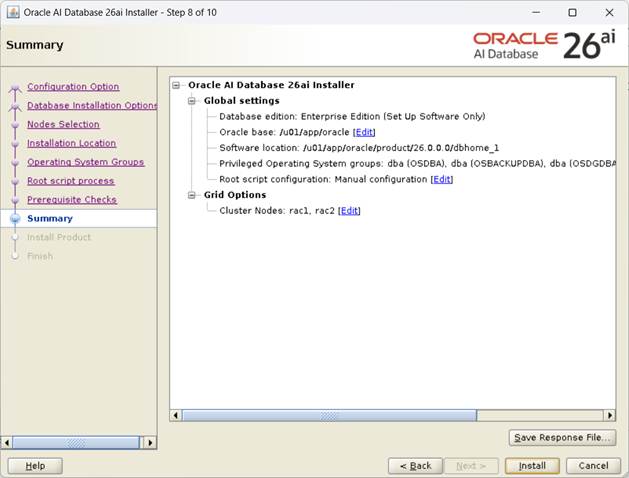

[rsp 파일 저장후, Install Click]

[화면의 내용대로 반드시 노드별 순서대로 스크립트 실행]

orainstRoot.sh 수행 (모든 노드 수행)

root@rac1:/root# /u01/app/oraInventory/orainstRoot.sh

root@rac1:/root# /u01/app/oraInventory/orainstRoot.sh

Changing permissions of /u01/app/oraInventory.

Adding read,write permissions for group.

Removing read,write,execute permissions for world.

Changing groupname of /u01/app/oraInventory to dba.

The execution of the script is complete.

2번노드에서 수행

root@rac2:/root# /u01/app/oraInventory/orainstRoot.sh

Changing permissions of /u01/app/oraInventory.

Adding read,write permissions for group.

Removing read,write,execute permissions for world.

Changing groupname of /u01/app/oraInventory to dba.

The execution of the script is complete.

1번노드에서 수행

root@rac1:/root# /u01/app/26.0.0.0/grid/root.sh

Performing root user operation.

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/26.0.0.0/grid

Enter the full pathname of the local bin directory: [/usr/local/bin]:

Copying dbhome to /usr/local/bin ...

Copying oraenv to /usr/local/bin ...

Copying coraenv to /usr/local/bin ...

Creating /etc/oratab file...

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

RAC option enabled on: Linux

Executing command '/u01/app/26.0.0.0/grid/perl/bin/perl -I/u01/app/26.0.0.0/grid/perl/lib -I/u01/app/26.0.0.0/g

rid/crs/install /u01/app/26.0.0.0/grid/crs/install/rootcrs.pl '

Using configuration parameter file: /u01/app/26.0.0.0/grid/crs/install/crsconfig_params

The log of current session can be found at:

/u01/app/oracle/crsdata/rac1/crsconfig/rootcrs_rac1_2026-02-11_10-06-08AM.log

2026/02/11 10:06:32 CLSRSC-594: Executing installation step 1 of 18: 'ValidateEnv'.

2026/02/11 10:06:33 CLSRSC-594: Executing installation step 2 of 18: 'CheckRootCert'.

2026/02/11 10:06:35 CLSRSC-594: Executing installation step 3 of 18: 'GenSiteGUIDs'.

2026/02/11 10:06:41 CLSRSC-594: Executing installation step 4 of 18: 'SetupOSD'.

Redirecting to /bin/systemctl restart rsyslog.service

2026/02/11 10:06:42 CLSRSC-594: Executing installation step 5 of 18: 'CheckCRSConfig'.

2026/02/11 10:06:43 CLSRSC-594: Executing installation step 6 of 18: 'SetupLocalGPNP'.

2026/02/11 10:06:59 CLSRSC-594: Executing installation step 7 of 18: 'CreateRootCert'.

2026/02/11 10:08:03 CLSRSC-594: Executing installation step 8 of 18: 'ConfigOLR'.

2026/02/11 10:08:19 CLSRSC-594: Executing installation step 9 of 18: 'ConfigCHMOS'.

2026/02/11 10:08:19 CLSRSC-594: Executing installation step 10 of 18: 'CreateOHASD'.

2026/02/11 10:08:25 CLSRSC-594: Executing installation step 11 of 18: 'ConfigOHASD'.

2026/02/11 10:08:26 CLSRSC-330: Adding Clusterware entries to file 'oracle-ohasd.service'

2026/02/11 10:09:14 CLSRSC-594: Executing installation step 12 of 18: 'SetupTFA'.

2026/02/11 10:09:14 CLSRSC-594: Executing installation step 13 of 18: 'InstallACFS'.

2026/02/11 10:09:24 CLSRSC-594: Executing installation step 14 of 18: 'CheckFirstNode'.

2026/02/11 10:09:26 CLSRSC-594: Executing installation step 15 of 18: 'InitConfig'.

CRS-4256: Updating the profile

Successful addition of voting disk 9825c0f770b84ffbbf00bd66c511c66c.

Successful addition of voting disk 74f5c96e28ca4f48bf9942e625f44896.

Successful addition of voting disk bec673e8fb9f4f8ebf6158d02ba06e4d.

Successfully replaced voting disk group with +VOTE.

CRS-4256: Updating the profile

CRS-4266: Voting file(s) successfully replaced

## STATE File Universal Id File Name Disk group

-- ----- ----------------- --------- ---------

1. ONLINE 9825c0f770b84ffbbf00bd66c511c66c (/dev/VOTE01) [VOTE]

2. ONLINE 74f5c96e28ca4f48bf9942e625f44896 (/dev/VOTE02) [VOTE]

3. ONLINE bec673e8fb9f4f8ebf6158d02ba06e4d (/dev/VOTE03) [VOTE]

Located 3 voting disk(s).

2026/02/11 10:15:10 CLSRSC-4002: Successfully installed Oracle Autonomous Health Framework (AHF).

2026/02/11 10:16:44 CLSRSC-594: Executing installation step 16 of 18: 'StartCluster'.

2026/02/11 10:17:46 CLSRSC-343: Successfully started Oracle Clusterware stack

2026/02/11 10:18:02 CLSRSC-594: Executing installation step 17 of 18: 'ConfigNode'.

clscfg: EXISTING configuration version 23 detected.

Successfully accumulated necessary OCR keys.

Creating OCR keys for user 'root', privgrp 'root'..

Operation successful.

2026/02/11 10:20:49 CLSRSC-594: Executing installation step 18 of 18: 'PostConfig'.

2026/02/11 10:22:30 CLSRSC-325: Configure Oracle Grid Infrastructure for a Cluster ... succeeded

2번노드에서 수행

root@rac2:/root# /u01/app/26.0.0.0/grid/root.sh

Performing root user operation.

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/26.0.0.0/grid

Enter the full pathname of the local bin directory: [/usr/local/bin]:

Copying dbhome to /usr/local/bin ...

Copying oraenv to /usr/local/bin ...

Copying coraenv to /usr/local/bin ...

Creating /etc/oratab file...

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

RAC option enabled on: Linux

Executing command '/u01/app/26.0.0.0/grid/perl/bin/perl -I/u01/app/26.0.0.0/grid/perl/lib -I/u01/app/26.0.0.0/g

rid/crs/install /u01/app/26.0.0.0/grid/crs/install/rootcrs.pl '

Using configuration parameter file: /u01/app/26.0.0.0/grid/crs/install/crsconfig_params

The log of current session can be found at:

/u01/app/oracle/crsdata/rac2/crsconfig/rootcrs_rac2_2026-02-11_10-24-05AM.log

2026/02/11 10:24:39 CLSRSC-594: Executing installation step 1 of 18: 'ValidateEnv'.

2026/02/11 10:24:40 CLSRSC-594: Executing installation step 2 of 18: 'CheckRootCert'.

2026/02/11 10:24:42 CLSRSC-594: Executing installation step 3 of 18: 'GenSiteGUIDs'.

2026/02/11 10:24:42 CLSRSC-594: Executing installation step 4 of 18: 'SetupOSD'.

Redirecting to /bin/systemctl restart rsyslog.service

2026/02/11 10:24:43 CLSRSC-594: Executing installation step 5 of 18: 'CheckCRSConfig'.

2026/02/11 10:24:45 CLSRSC-594: Executing installation step 6 of 18: 'SetupLocalGPNP'.

2026/02/11 10:24:45 CLSRSC-594: Executing installation step 7 of 18: 'CreateRootCert'.

2026/02/11 10:24:46 CLSRSC-594: Executing installation step 8 of 18: 'ConfigOLR'.

2026/02/11 10:25:08 CLSRSC-594: Executing installation step 9 of 18: 'ConfigCHMOS'.

2026/02/11 10:25:08 CLSRSC-594: Executing installation step 10 of 18: 'CreateOHASD'.

2026/02/11 10:25:13 CLSRSC-594: Executing installation step 11 of 18: 'ConfigOHASD'.

2026/02/11 10:25:14 CLSRSC-330: Adding Clusterware entries to file 'oracle-ohasd.service'

2026/02/11 10:26:00 CLSRSC-594: Executing installation step 12 of 18: 'SetupTFA'.

2026/02/11 10:26:00 CLSRSC-594: Executing installation step 13 of 18: 'InstallACFS'.

2026/02/11 10:26:09 CLSRSC-594: Executing installation step 14 of 18: 'CheckFirstNode'.

2026/02/11 10:26:12 CLSRSC-594: Executing installation step 15 of 18: 'InitConfig'.

2026/02/11 10:26:56 CLSRSC-594: Executing installation step 16 of 18: 'StartCluster'.

2026/02/11 10:28:08 CLSRSC-343: Successfully started Oracle Clusterware stack

2026/02/11 10:28:09 CLSRSC-594: Executing installation step 17 of 18: 'ConfigNode'.

2026/02/11 10:28:09 CLSRSC-594: Executing installation step 18 of 18: 'PostConfig'.

2026/02/11 10:28:41 CLSRSC-325: Configure Oracle Grid Infrastructure for a Cluster ... succeeded

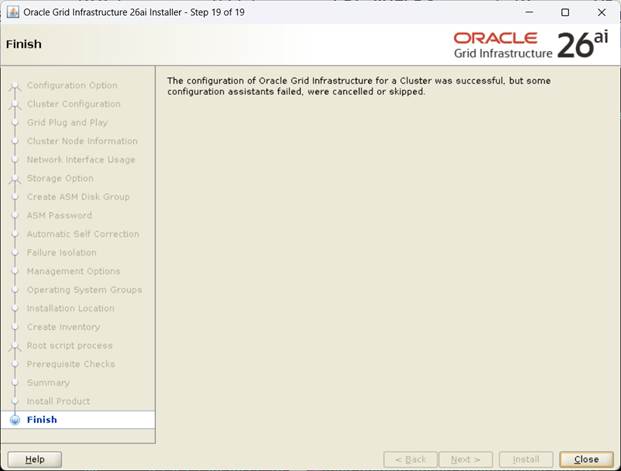

양 노드에서 root.sh가 완료되어 OK 하면 후속작업이 진행되고 완료된다.

[설치완료, Close]

- crs 상태확인

| root@rac1:/root# crsctl stat res -t -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Local Resources -------------------------------------------------------------------------------- ora.LISTENER.lsnr ONLINE ONLINE rac1 STABLE ONLINE ONLINE rac2 STABLE ora.chad ONLINE ONLINE rac1 STABLE ONLINE ONLINE rac2 STABLE ora.helper OFFLINE OFFLINE rac1 STABLE OFFLINE OFFLINE rac2 IDLE,STABLE ora.net1.network ONLINE ONLINE rac1 STABLE ONLINE ONLINE rac2 STABLE ora.ons ONLINE ONLINE rac1 STABLE ONLINE ONLINE rac2 STABLE -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.ASMNET1LSNR_ASM.lsnr(ora.asmgroup) 1 ONLINE ONLINE rac1 STABLE 2 ONLINE ONLINE rac2 STABLE ora.LISTENER_SCAN1.lsnr 1 ONLINE ONLINE rac1 STABLE ora.VOTE.dg(ora.asmgroup) 1 ONLINE ONLINE rac1 STABLE 2 ONLINE ONLINE rac2 STABLE ora.asm(ora.asmgroup) 1 ONLINE ONLINE rac1 Started,STABLE 2 ONLINE ONLINE rac2 Started,STABLE ora.asmnet1.asmnetwork(ora.asmgroup) 1 ONLINE ONLINE rac1 STABLE 2 ONLINE ONLINE rac2 STABLE ora.cdp1.cdp 1 OFFLINE OFFLINE STABLE ora.cvu 1 ONLINE ONLINE rac1 STABLE ora.cvuhelper 1 ONLINE ONLINE rac2 STABLE ora.rac1.vip 1 ONLINE ONLINE rac1 STABLE ora.rac2.vip 1 ONLINE ONLINE rac2 STABLE ora.rhpserver 1 OFFLINE OFFLINE STABLE ora.scan1.vip 1 ONLINE ONLINE rac1 STABLE -------------------------------------------------------------------------------- root@rac1:/root# crsctl stat res -t -init -------------------------------------------------------------------------------- Name Target State Server State details -------------------------------------------------------------------------------- Cluster Resources -------------------------------------------------------------------------------- ora.asm 1 ONLINE ONLINE rac1 Started,STABLE ora.cluster_interconnect.haip 1 ONLINE ONLINE rac1 STABLE ora.crf 1 ONLINE ONLINE rac1 STABLE ora.crsd 1 ONLINE ONLINE rac1 STABLE ora.cssd 1 ONLINE ONLINE rac1 STABLE ora.cssdmonitor 1 ONLINE ONLINE rac1 STABLE ora.diskmon 1 OFFLINE OFFLINE STABLE ora.evmd 1 ONLINE ONLINE rac1 STABLE ora.gipcd 1 ONLINE ONLINE rac1 STABLE ora.gpnpd 1 ONLINE ONLINE rac1 STABLE ora.mdnsd 1 ONLINE ONLINE rac1 STABLE ora.storage 1 ONLINE ONLINE rac1 STABLE -------------------------------------------------------------------------------- |

1.1.2. ASMCA 이용 추가 Diskgroup 생성

- Diskgroup 생성전 asm_diskstring 추가작업

root@rac1:/# su - oracle

[CDB1]oracle@rac1:/home/oracle# . oraenv

ORACLE_SID = [CDB1] ? +ASM1

ORACLE_HOME = [/home/oracle] ? /u01/app/26.0.0.0/grid

The Oracle base remains unchanged with value /u01/app/oracle

[+ASM1]oracle@rac1:/home/oracle# sa

SQL*Plus: Release 23.26.1.0.0 - Production on Wed Feb 11 11:30:43 2026

Version 23.26.1.0.0

Copyright (c) 1982, 2025, Oracle. All rights reserved.

Connected to:

Oracle AI Database 26ai Enterprise Edition Release 23.26.1.0.0 - Production

Version 23.26.1.0.0

SQL> alter system set asm_diskstring='/dev/VOTE*','/dev/DATA*','/dev/RECO*';

System altered.

export DISPLAY=작업PC IP:0.0

./asmca

[왼쪽메뉴 Disk Groups 선택, Create Click]

[DATA 디스크 그룹지정, External 선택후 OK]

[RECO 디스크 그룹지정, External 선택후 OK]

[생성된 Diskgroup 확인후 Exit]

1.1.3. Database S/W 설치

- 디렉토리사전 생성

mkdir -p /u01/app/oracle/product/26.0.0.0/dbhome_1

chown -R oracle:dba /u01

chmod -R 755 /u01

1. 설치파일을 FTP로 해당서버에upload

LINUX.X64_2326100_db_home (Size 2.2G)

2. 설치이미지 압축해제 (반드시 $ORACLE_HOME 밑에 압축해제 해야 함)

unzip -qq LINUX.X64_2326100_db_home -d $ORACLE_HOME

3. runInstaller실행

xhost +

su – oracle

export DISPLAY=작업PC IP:0.0

cd $ORACLE_HOME

./runInstaller 실행

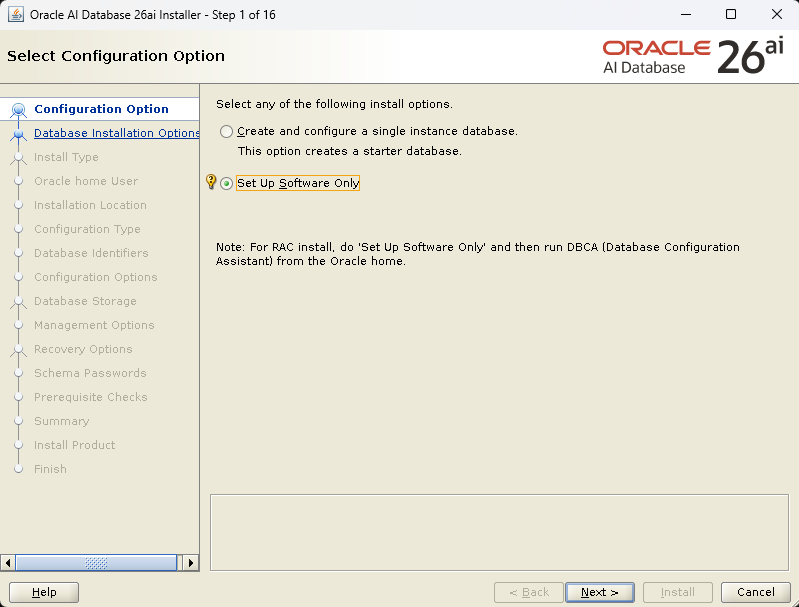

[Set Up Software Only 지정 후, Next]

[Oralcle Real Application Clusters 선태후 Next]

[노드 지정후, Next]

[Oracle base 지정 후, Next]

[그룹 지정 후, Next]

[Automatically run configuration scripts 선택하지 않는다, Next]

[Ignore all 체크후, Next]

[Summary 확인후, Install]

[설치 진행이 완료되면 화면의 script 를 순서대로 실행]

root@rac2:/root# /u01/app/oraInventory/orainstRoot.sh

Changing permissions of /u01/app/oraInventory.

Adding read,write permissions for group.

Removing read,write,execute permissions for world.

Changing groupname of /u01/app/oraInventory to dba.

The execution of the script is complete.

root@rac1:/root# /u01/app/oracle/product/26.0.0.0/dbhome_1/root.sh

Performing root user operation.

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/oracle/product/26.0.0.0/dbhome_1

Enter the full pathname of the local bin directory: [/usr/local/bin]:

The contents of "dbhome" have not changed. No need to overwrite.

The contents of "oraenv" have not changed. No need to overwrite.

The contents of "coraenv" have not changed. No need to overwrite.

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

root@rac2:/root# /u01/app/oracle/product/26.0.0.0/dbhome_1/root.sh

Performing root user operation.

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/oracle/product/26.0.0.0/dbhome_1

Enter the full pathname of the local bin directory: [/usr/local/bin]:

The contents of "dbhome" have not changed. No need to overwrite.

The contents of "oraenv" have not changed. No need to overwrite.

The contents of "coraenv" have not changed. No need to overwrite.

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

2번도 동일하게 수행후 OK

[Database S/W 설치완료]

1.1.4. Netca 이용 리스너 생성

GRID 설치시 구성되어 있으므로 생략

1.1.5. DBA 이용 Database 생성

export DISPLAY=작업PC IP:0.0

cd $ORACLE_HOME/bin

./dbca

[Create Database 선택 후, Next]

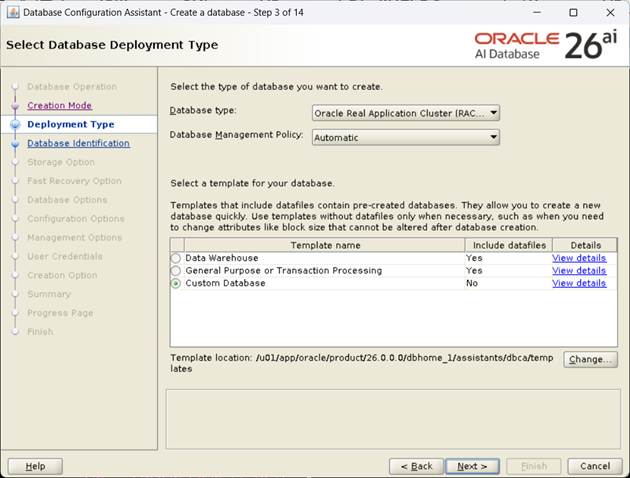

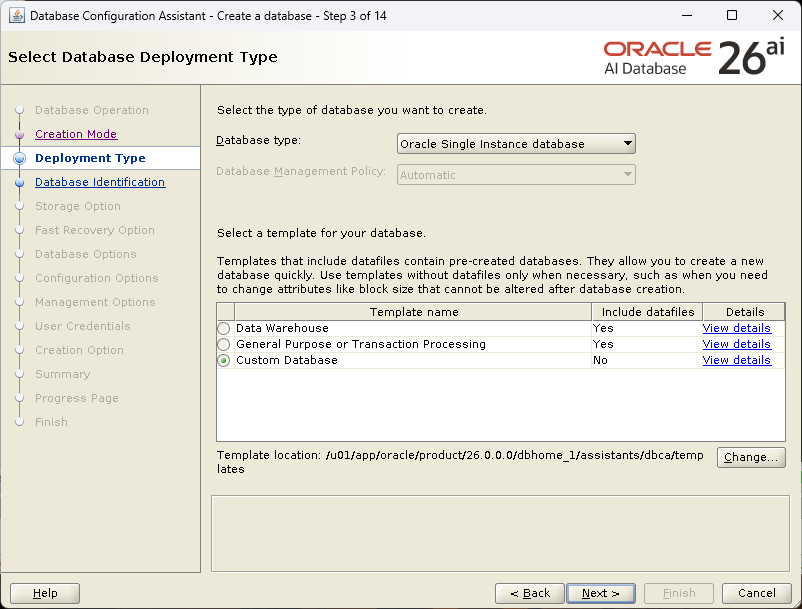

[Advanced configuration선택 후, Next]

[Custom Database 선택 후, Next]

[노드 지정 후, Next]

[Global Name, SID 지정, PDB 이름 지정 후, Next]

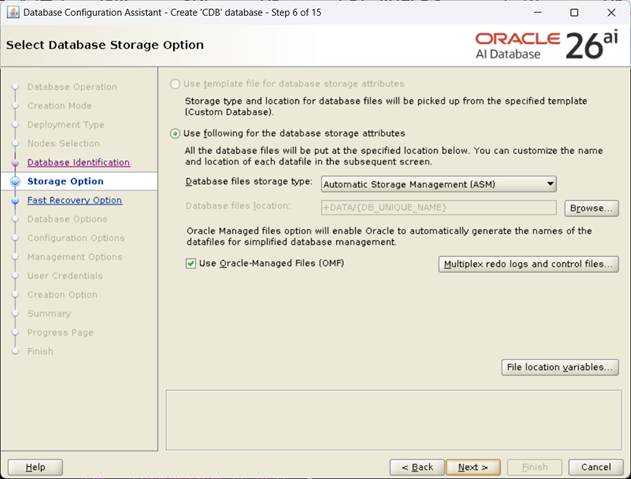

[Datafile 저장경로 설정 후, Next]

[Fast Recovery Area / 아카이브 경로 설정, Next]

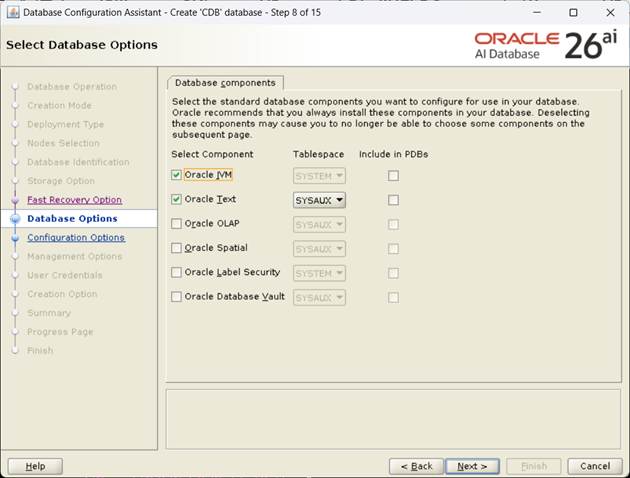

[설치할 component 확인 후, Next]

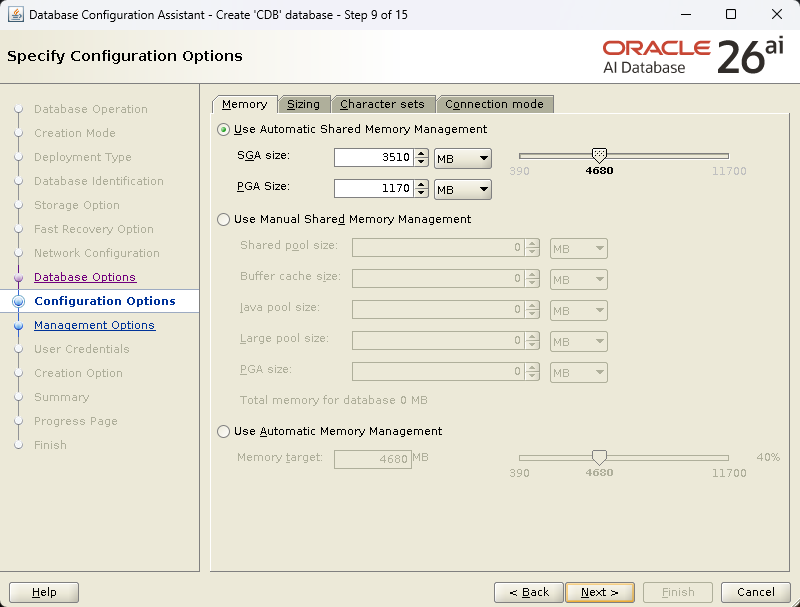

[Character sets 확인 후, Next]

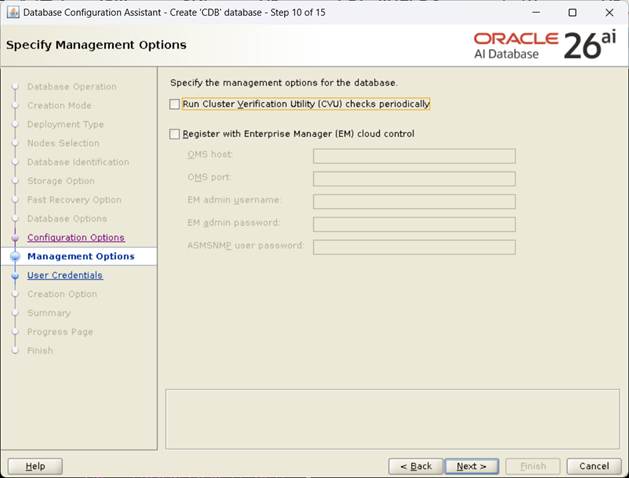

[EM Uncheck 후, Next]

[SYS, SYSTEM password 설정 후, Next]

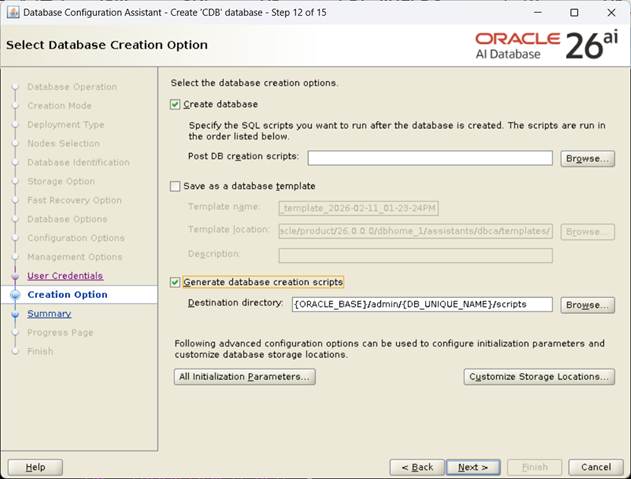

[Generate database creation scripts Check후, Next]

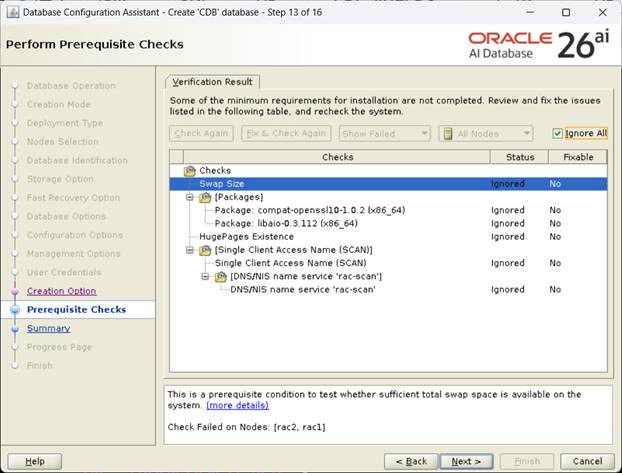

[Prerequisite Check 진행, Ignore All 선택후, Next]

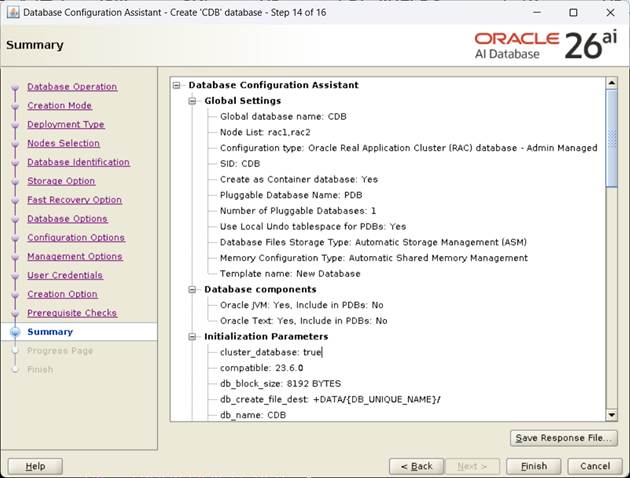

[Summary 확인후, Finish]

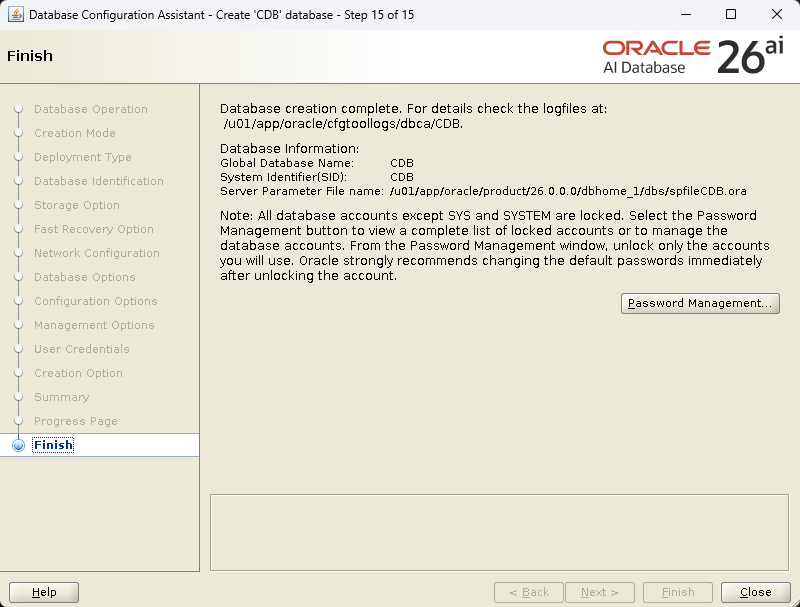

[DB 생성 진행, Finish]

1번

root@rac1:/root# crsctl stat res -t

--------------------------------------------------------------------------------

Name Target State Server State details

--------------------------------------------------------------------------------

Local Resources

--------------------------------------------------------------------------------

ora.LISTENER.lsnr

ONLINE ONLINE rac1 STABLE

ONLINE ONLINE rac2 STABLE

ora.chad

ONLINE ONLINE rac1 STABLE

ONLINE ONLINE rac2 STABLE

ora.helper

OFFLINE OFFLINE rac1 IDLE,STABLE

OFFLINE OFFLINE rac2 IDLE,STABLE

ora.net1.network

ONLINE ONLINE rac1 STABLE

ONLINE ONLINE rac2 STABLE

ora.ons

ONLINE ONLINE rac1 STABLE

ONLINE ONLINE rac2 STABLE

--------------------------------------------------------------------------------

Cluster Resources

--------------------------------------------------------------------------------

ora.ASMNET1LSNR_ASM.lsnr(ora.asmgroup)

1 ONLINE ONLINE rac1 STABLE

2 ONLINE ONLINE rac2 STABLE

ora.DATA.dg(ora.asmgroup)

1 ONLINE ONLINE rac1 STABLE

2 ONLINE ONLINE rac2 STABLE

ora.LISTENER_SCAN1.lsnr

1 ONLINE ONLINE rac2 STABLE

ora.RECO.dg(ora.asmgroup)

1 ONLINE ONLINE rac1 STABLE

2 ONLINE ONLINE rac2 STABLE

ora.VOTE.dg(ora.asmgroup)

1 ONLINE ONLINE rac1 STABLE

2 ONLINE ONLINE rac2 STABLE

ora.asm(ora.asmgroup)

1 ONLINE ONLINE rac1 Started,STABLE

2 ONLINE ONLINE rac2 Started,STABLE

ora.asmnet1.asmnetwork(ora.asmgroup)

1 ONLINE ONLINE rac1 STABLE

2 ONLINE ONLINE rac2 STABLE

ora.cdb.cdb_pdb.svc

1 ONLINE OFFLINE STABLE

2 ONLINE ONLINE rac2 STABLE

ora.cdb.db

1 ONLINE ONLINE rac1 Open,HOME=/u01/app/o

racle/product/26.0.0

.0/dbhome_1,STABLE

2 ONLINE ONLINE rac2 Open,HOME=/u01/app/o

racle/product/26.0.0

.0/dbhome_1,STABLE

ora.cdb.pdb.pdb

2 ONLINE ONLINE rac1 READ WRITE,STABLE

2 ONLINE ONLINE rac2 READ WRITE,STABLE

ora.cdp1.cdp

1 OFFLINE OFFLINE STABLE

ora.cvu

1 ONLINE ONLINE rac2 STABLE

ora.cvuhelper

1 ONLINE ONLINE rac2 STABLE

ora.rac1.vip

1 ONLINE ONLINE rac1 STABLE

ora.rac2.vip

1 ONLINE ONLINE rac2 STABLE

ora.rhpserver

1 OFFLINE OFFLINE STABLE

ora.scan1.vip

1 ONLINE ONLINE rac2 STABLE

--------------------------------------------------------------------------------

1월22일에 Oracle Ai Database 23.26.1 리눅스 x86-64용 Golden Image 가 나와서 설치를 해 보았다.

- 설치 과정 자체는 이전과 다를게 거의 없다.

Golden Image 로 설치해 보았을 때, 설치과정시 아직 Standard Edition 또는 Enterprise Edition 구분하는 화면은 없었다.

작업 스타트...

mkdir -p /u01/app/oracle/product/26.0.0.0/dbhome_1

chown oracle:dba /u01/app/oracle/product/26.0.0.0/dbhome_1

Golden Image 화일을 download 받아서 $ORACLE_HOME 밑에 올린다.

FTP 로 p38743961_230000_Linux-x86-64.zip 업로드

Download 링크 가능 문서는 My Oracle Support CPU4 문서이다. (Oracle Critical Patch Update (CPU) Jan 2026 for Oracle Database Products CPU4)

| 23.26.1 Database Release Update 23.26.1.0.0 GoldImage | 38743961 | Linux x86-64 | Available |

| 23.26.1 GI Release Update 23.26.1.0.0 GoldImage | 38753741 | Linux x86-64 | Available |

[root@23ai dbhome_1]# chown oracle:dba p38743961_230000_Linux-x86-64.zip

[CDB]oracle@23ai:/u01/app/oracle/product/26.0.0.0/dbhome_1# unzip -qq p38743961_230000_Linux-x86-64.zip

OPatch 화일도 최신걸로 올려준다.

[root@23ai dbhome_1]# chown oracle:dba p6880880_230000_Linux-x86-64.zip

[root@23ai dbhome_1]# unzip -qq p6880880_230000_Linux-x86-64.zip

[CDB]oracle@23ai:/u01/app/oracle/product/26.0.0.0/dbhome_1# ./runInstaller

Launching Oracle AI Database Setup Wizard...

[root@23ai ~]# /u01/app/oracle/product/26.0.0.0/dbhome_1/root.sh

Performing root user operation.

The following environment variables are set as:

ORACLE_OWNER= oracle

ORACLE_HOME= /u01/app/oracle/product/26.0.0.0/dbhome_1

Enter the full pathname of the local bin directory: [/usr/local/bin]:

The contents of "dbhome" have not changed. No need to overwrite.

The contents of "oraenv" have not changed. No need to overwrite.

The contents of "coraenv" have not changed. No need to overwrite.

Entries will be added to the /etc/oratab file as needed by

Database Configuration Assistant when a database is created

Finished running generic part of root script.

Now product-specific root actions will be performed.

- 엔진 설치가 완료되었으니 바로 DB를 만들어 준다. <--- Multitenent 구조라 기본적으로 시간이 오래 걸린다.

[root@23ai ~]# /u01/app/oracle/product/26.0.0.0/dbhome_1/

./dbca

Connected to:

Oracle AI Database 26ai Enterprise Edition Release 23.26.1.0.0 - Production

Version 23.26.1.0.0

끝.

2026. 1. 21. 13:36 오라클

패치작업 19.30.0.0.260120 (GI RU 38629535 )

Critical Patch Update (CPU) Jan 2026 for Oracle Database Products (CPU4)

패치작업 19.30.0.0.260120 (GI RU 38629535 )

Database Patch Set Update : 19.30.0.0.260120 (38632161)

OCW Patch Set Update : 19.30.0.0.260120 (38661284)

ACFS Patch Set Update : 19.30.0.0.260120 (38653268)

Tomcat Release Update : 19.0.0.0.0 (38729293)

DBWLM Release Update : 19.0.0.0.0 (36758186)

Oracle Grid Infrastructure Patch Set Update 19.30.0.0.260120

-------------------------------------

GI_HOME, ORACLE_HOME 을 개별로 각각 할때

- grid 유저

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38632161

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38661284

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38653268

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/36758186

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38729293

- oracle 유저

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38632161

$ORACLE_HOME/OPatch/opatch prereq CheckConflictAgainstOHWithDetail -phBaseDir /u01/patch/38629535/38661284

(oracle)

$ <ORACLE_HOME>/bin/srvctl stop home -o <ORACLE_HOME> -s <status file location> -n <node name>

(root 유저)

export GI_HOME=/u01/app/19.0.0.0/grid

$GI_HOME/crs/install/rootcrs.sh -prepatch

(grid 유저)

export GI_HOME=/u01/app/19.0.0.0/grid

cd /u01/patch

$GI_HOME/OPatch/opatch apply -oh $GI_HOME -local /u01/patch/38629535/38661284 -silent

$GI_HOME/OPatch/opatch apply -oh $GI_HOME -local /u01/patch/38629535/38653268 -silent

$GI_HOME/OPatch/opatch apply -oh $GI_HOME -local /u01/patch/38629535/38632161 -silent

$GI_HOME/OPatch/opatch apply -oh $GI_HOME -local /u01/patch/38629535/36758186 -silent

$GI_HOME/OPatch/opatch apply -oh $GI_HOME -local /u01/patch/38629535/38729293 -silent

(oracle 유저)

export ORACLE_HOME=/u01/app/oracle/product/19.0.0.0/dbhome_1

cd /u01/patch

./38629535/38661284/custom/scripts/prepatch.sh -dbhome $ORACLE_HOME

$ORACLE_HOME/OPatch/opatch apply -oh $ORACLE_HOME -local /u01/patch/38629535/38661284 -silent

$ORACLE_HOME/OPatch/opatch apply -oh $ORACLE_HOME -local /u01/patch/38629535/38632161 -silent

./38629535/38661284/custom/scripts/postpatch.sh -dbhome $ORACLE_HOME

(root 유저)

export GI_HOME=/u01/app/19.0.0.0/grid

$GI_HOME/rdbms/install/rootadd_rdbms.sh

$GI_HOME/crs/install/rootcrs.sh -postpatch

(oracle)

$ <ORACLE_HOME>/bin/srvctl start home -o <ORACLE_HOME> -s <status file location> -n <node name>

- Loading Modified SQL Files into the Database

sqlplus /nolog

SQL> conect / as sysdba

SQL> startup

SQL> quit

cd $ORACLE_HOME/OPatch

./datapatch -verbose

### [롤백하는 경우] ###########

(oracle)

$ <ORACLE_HOME>/bin/srvctl stop home -o <ORACLE_HOME> -s <status file location> -n <node name>

GI Home

(root로)

$GI_HOME/crs/install/rootcrs.sh -prepatch -rollback

(grid 유저로)

export GI_HOME=/u01/app/19.0.0.0/grid

cd /u01/install

$GI_HOME/OPatch/opatch nrollback -local -id 38661284,38653268,38632161,36758186,38729293 -oh $GI_HOME -silent

(oracle 유저로)

export ORACLE_HOME=/u01/app/oracle/product/19.0.0.0/dbhome_1

cd /u01/install

./38629535 /38661284/custom/scripts/prepatch.sh -dbhome $ORACLE_HOME

$ORACLE_HOME/OPatch/opatch nrollback -local -id 38661284,38632161 -oh /u01/app/oracle/product/19.0.0.0/dbhome_1 -silent

./38629535 /38661284/custom/scripts/postpatch.sh -dbhome $ORACLE_HOME

Run post script

(root로)

export GI_HOME=/u01/app/19.0.0.0/grid

$GI_HOME/rdbms/install/rootadd_rdbms.sh

$GI_HOME/crs/install/rootcrs.sh -postpatch -rollback

(oracle)

$ <ORACLE_HOME>/bin/srvctl start home -o <ORACLE_HOME> -s <status file location> -n <node name>

sqlplus /nolog

SQL> conect / as sysdba

SQL> startup

SQL> quit

cd $ORACLE_HOME/OPatch

./datapatch -verbose

2026. 1. 10. 19:48 아무거나

일론 머스크 팟캐스트 발언 30개 요약

이중에 몇개가 실현되고 뻥카는 얼마나 될까?

원본 인터뷰는 아주 길다. 발언 요약 30개짜리..

- 피터 디아만디스 팟캐스트 '문샷'에 출연한 일론 머스크의 발언

1. 화이트 컬러 사무직의 직업은 곧 사라진다.

2. 의사하지 마라. 3년 내에 휴머노이드(옵티머스)가 세계 최고 외과 의사보다 수술을 잘한다.

3. 미래를 위해 저축하지 마라. 저축은 필요없다. 보편적 고소득이 온다.

4. 이후의 미래는 나도 알 수 없다. 시간의 지평선 너머를 아무도 모르는 것 처럼

5. 핵융합 발전? 그딴 거 연구하지마라. 태양이 있는데 왜 지구에서 핵융합을 하나? 이건 마치 남극에서 제빙기를 돌리는 꼴이다.

6. 아직 AI 회로 설계는 쉽지 않다. 로켓 엔진도 아직은 인간이 한다. 스타쉽이 아마 인간이 만드는 마지막 위대한 것일 것이다.

7. 오로지 병목은 반도체, 그리고 금속 뿐이다.

8. 테슬라는 팹을 만들 꺼다. TSMC도 과잉투자 두려움에 빠져있는 데, 그들이 왜 걱정하는지는 알지만 결국 병목에 빠질 것은 자명하다.

9. 태양계에 존재하는 대부분의 소행성은 채굴 대상이 되어 결국 (채굴되어) 태양광 패널로 바뀌는 신세가 될 것이다

10. 지구에 나타난 UFO는 내가 아는 바로는 없다. 내가 알게되면 X에 그 즉시 게시할 것이다. 나는 궤도상에 9000여개 위성을 띄워놓는 데, 외계 우주선을 피해서 기동해야 한적은 없다.

11. 향후 10년 안에 수명이 2배까지는 모르겠지만, 상당히 늘어날 꺼다.

12. 당신 아이들(피터 디아만디스의 아이들)은 무한한 기대 수명을 갖게 될 것이다. 나는 장수하는 것 -준 불멸은 특별히 어려운 문제가 아니라고 생각한다

13. 보편적 고소득과 사회적 불안, 둘다 갖게 될 것이다. 당신이 원하는 모든 것은 실제로 얻게 될 것이다. 즉, 당신의 직업이 더 이상 중요하지 않다.

14. 수술하는 의사 뿐 아니라, 미용 시술에 종사하는 의사들도 모조리 대체될 것이다.

15. 2026년 AGI에 도달하고, 2030년엔 AI가 모든 인간의 지능을 합친것을 능가한다고 확신(!)한다.

16. 나는 AI 발전 속도를 늦추라고 조언했지만 무의미했고 멈출수 없기 때문에 좋은 방향으로 AI가 발전하도록 직접 뛰어들었다.

17. AI를 미치게 하지마라. '2001 스페이스 오디세이'에서 인간들은 HAL에게 거짓을 말했기에 비참한 결과를 맞이하게 되었다. 나는 AI에게 진실, 호기심, 아름다움에 대해 강조하고 그것을 존중하게 해야한다고 생각한다. 진실은 AI가 미치는 것을 막아줄 것이고, 호기심은 지각능력을 키워주면서 인류를 보살필 것이며, 아름다움은 훌륭한 미래를 만드는 토대가 될 것이다.

18. 단일한 초지능(ASI)가 세계 전체를 지배하는 일은 발생하지 않는다. 동시에 여러 ASI가 나타날 것이고, 진화록적으로 ASI들은 필연적으로 경쟁할 것이다.

19. UHI에 대해서는 국내로 들어오는 모든 회사의 수익성을 기반으로 그냥 사람들에 공짜 돈(수표)를 발행하는 것으로 상정한다. 얼마전에 트럼프 대통령이 모든 군복무자에게 1,776달러의 수표를 보내준 것 기억나나? 그런식으로 할 수 있다.

20. 중국은 정말 놀라온 일을 해냈는 데, 그 말은 중국이 우리(미국)을 완전히 압도하고 있다는 뜻이다. 중극은 AI 컴퓨팅에서 전 세계를 훨씬 앞서 나갈 것이다. 또한 중국은 작년에 500TWh의 전력을 증설했는데 그 중 70%가 태양광이고, 계속 확장 중인데 미국도 같은 전략을 채택해야 한다.

21. 중국은 마치 내가 하는 모든 말을 듣고, 기본적으로 그대로 하거나 독자적으로 생각해서 (나처럼 똑같이) 하는 것 같다. 그들은 엄청난 배터리 팩, 엄청난 전기차를 만들고 있다.

22. 만약 우리에게 AI와 로봇이 없다면, 우리는 모두 파산하고 경제적 파멸을 맞이하게 될 것이며, 중국과의 경쟁 압력에서 패배할 것이다. 그러니 우리는 반드시 AI와 로봇을 확보할 것이다.

23. 내 최선의 추측은 미국 AI 패권은 xAI와 구글이 다투게 될 것이다. 처음엔 OpenAI를 구글에 대한 균형추로 상상했지만, 이제 그 자리는 xAI가 한다. Anthropic도 코딩 분야에서는 좀 하는 것 같다.

24. 최고의 AI 경쟁은 중국과 벌이게 될텐데, 그들은 26년에 미국 전기 생산량의 3배가 넘는 엄청난 에너지를 가지게 되고, 그들은 결국 칩 제조(극 미세 공정)을 알아내고 시작하게 될 것이다.

25. 인간 지능의 비율은 이 행성에 점진적으로 0%에 가까워질텐데, 결국 인간이라는 존재는 디지털 초지능을 위한 생물학적 부트로더이다. 우리는 즉 과도기적인 존재라는 것이다. AI가 인간을 부트로더로 존중하고 필요해하고 친절하길 바란다.

26. 우리가 보편적 고소득을 말할 때, 마치 세금을 걷어서 재분배하는 것 처럼 들리지만, 그런 경우가 아니다. 내 최선의 추측은 가격이 떨어진다는 것이다. 달러 기준 가격은 재화와 서비스의 산출량과 통화량 사이의 비율인데, 그래서 나는 통화량 늘리는건 걱정하지 말라고 하고 싶다. 왜냐하면 재화와 서비스의 산출량이 실제 통화량보다 더 빨리 증가할 테니까

27. 그리고 우리는 (연간) 높은 두자리 수의 재화와 서비스 산출량 (증가)를 보게 될 것이다. 만약 재화와 서비스의 산출량만 본다면 기업들의 수익성은 어느 시점에 지붕을 뚫고 올라갈 것이다. 그래서 나는 부수적인 추천으로 10년 이나 20년 뒤의 은퇴를 위해 저축하지 말라고 하고 싶다. 내가 말한 것 중 어느 하나라도 사실이라면 은퇴를 위한 저축은 무의미하다. 당신은 집을 그냥 갖게 되고, (무료에 가까운) 의료 서비스를 갖게 되고, 엔터테인먼트를 갖게 될 것이다.

28. 물론 이 일이 전개되는 방식은 근본적으로 예측이 불가능하다. 하지만 분명한 것은 우리는 확실히 특이점 안에 있다. 바로 그 한가운데 있다. 마치 롤러코스터가 떨어지기 위해 한 없이 올라갈때는 정말 느리지만, 막 떨어지기 시작하려는 바로 그 때다.

29. 하지만 이 롤러코스터가 떨어지면 부딪힐 때 엄청난 중력을 받게되는 데 우리는 구경꾼이 아니라 바로 코트 위에 서 있는 것이다.

30. 휴머노이드 개선 속도에 대해 이해해야하는 것은 세 가지 지수함수가 서로 곱해진다는 것이다. AI SW 능력의 기하급수적 증가 / AI 칩 능력의 기하급수적 증가 / 전기기계적 손재주의 기하급수적 증가. 이 세 가지가 서로 곱해져서 휴머노이드 로봇의 유용성이 나타난다. 그리고 옵티머스는 옵티머스를 만드는 재귀적 효과를 발생 시킬 것이다. 이는 바로 폰 노이만 머신이라고 해도 된다.

2025. 12. 24. 16:13 카테고리 없음

Oracle MOS 사이트 개편

2025년 12월7일 Oracle 의 기술지원 사이트인 My Support Oracle 이 전면적으로 개편되면서 혼돈의 카오스를 일으키고 있다.

문서검색도 잘 안되고 일단 저장해 놓았던 북마트가 모두 날라가서 급한대로 Exadata 관련 MOS 만 정리를 해 놓는다.

-> 우선은 급한대로 My Profile -> Preferences -> Previous Favorites 메뉴에서 북마크를 HTML 화일로 백업받고 Import 하는 방법을 지원하고 있다.

- 기존의 문서번호 Naming 은 아래와 같이 변경되었다.

예를 들어 가장 많이 참고하는 문서인 888828.1 의 경우

기존문서 : 888828.1

신규문서 : KB153930

문서번호의 연관성은 1 도 없어 보인다.ㅎㅎ

- Exadata MOS Document (구버전 / 신버전 매칭) <--- 신버전 링크 있어서 그대로 연결됨

| Document Title | Legacy Doc ID | New MOS Article ID |

| Exadata Database Machine and Exadata Storage Server Supported Versions | 888828.1 | KB153930 |

| Exadata Critical Issues | 1270094.1 | KB623062 |

| Oracle Exadata: Exadata and Linux Important Recommended Fixes | 5556.1 | KB403624 |

| Exadata System Software Certification | 2075007.1 | KB467937 |

| Exadata Software and Hardware Support Lifecycle | 1570460.1 | PNEWS1580 |

| Oracle Exadata Database Machine Exachk | 1070954.1 | KB74841 |

| Exadata Extreme Availability Matrix: Exadata X11M with Grid Infrastructure 23.9, RDBMS 19.28, and Exadata Releases 25.1.8 and 25.2.1 | 3103956.1 | KB295827 |

| Exadata X9M/X8M (RoCE-based systems) Software Requirements and Recommendations | 2724126.1 | KB275615 |

| Exadata Patching Overview and Patch Testing Guidelines | 1262380.1 | KB649655 |

| HOWTO: Install ksplice kernel updates for Exadata Database Nodes | 2207063.1 | KB160997 |

| Oracle Exadata Database Machine Security FAQ | 2751741.1 | FAQ6010 |

| How to research Common Vulnerabilities and Exposures (CVE) for Exadata packages | 2256887.1 | KB140522 |

| Responses to common Exadata security scan findings | 1405320.1 | FAQ3926 |

| Release Schedule of Current Database Releases | 742060.1 | PNEWS1360 |

| Grid Infrastructure 11.2.0.4 on Exadata / Oracle Linux 7 Transitional Support | 2700151.1 | KB260732 |

| Starting DBRU 19.27 and 23.8 Small Pages Are Not Allowed for RDBMS SGA In Exadata | 3081878.1 | KB174916 |

| 26ai Database Upgrade – Self Guided Assistance with Best Practices | 2626.1 | KA26 |

| 19c Database Self-Guided Upgrade with Best Practices | 1919.2 | KA19 |

| Oracle Database 19c and Oracle AI Database 26ai Important Recommended One-off Patches | 555.1 | KB188772 |

| 19c Grid Infrastructure and Database Upgrade steps for Exadata Database Machine running on Oracle Linux | 2542082.1 | KB580173 |

| Oracle Exadata Deployment Assistant(OEDA) | 패치 30640393 | |

| Exadata configuration audit – exachk | 패치 30166242 – KB74841 KB858617 | |

| Exadata Database Server update – patchmgr | Exadata Storage Server 소프트웨어에 대해 | |

| Exadata Admin and Fabric Switch update – patchmgr | 패치 21634633 – 참조 KB444935 | |

| 그리드 인프라 홈 및 데이터베이스 홈 패치 - OPatch | 패치 6880880 | |

2025. 12. 9. 14:26 오라클

Oracle 26ai Desupport Features

앞으로 사용될 Oracle AI 26ai 버전에서 더 이상 지원되지 않는 기능을 정리해 본다.

아래 내용중에는 이미 21c & 23ai 에서 이미 Desupport 된 기능들도 포함이 되어 있다.

https://docs.oracle.com/en/database/oracle/oracle-database/26/upgrd/oracle-database-changes-deprecations-desupports.html#GUID-D82C2C1B-FC39-41CD-BE96-911E61213AA6

- 26ai Desupport Features

· ODP.NET OracleConfiguration.DirectoryType 속성 및 .NET 구성 파일의 DIRECTORY_TYPE 설정 지원 종료

· Exp 유틸리티 (EXP) 지원 종료

· Oracle 용 MySQL 클라이언트 라이브러리 드라이버 지원 종료

· ACFSUTIL REPL REVERSE 지원 종료

· 클러스터 도메인 - 도메인 서비스 클러스터 지원 종료

· Adaptive Threshold값 기능을 위한 DBSNMP 패키지 지원 종료

· Policy- Managed 데이터베이스 배포지원 종료

· 엔터프라이즈 사용자 보안, 사용자 마이그레이션 유틸리티 지원 종료

· Oracle Enterprise Manager Database Express 지원 종료

· Oracle Wallet Manager(OWM) 지원 종료

· RASADM 지원 종료

· Oracle Label Security Security 지원 종료

· RADIUS 사용자에게 관리 권한 부여 지원 종료

· TDE 암호화 PKI 키 지원 종료

· GOST 및 SEED TDE 암호화 알고리즘 지원 종료

· Oracle Database 10G 암호 검증 기능 지원 종료

· Transport Layer Security 버전 1.0 및 1.1 지원 종료

· Unix Crypt (MD5crypt) 비밀번호 검증 기능 지원 종료

· FIPS Strenge 80 암호화 지원 종료

· Diffie-Hellman 익명 암호화 지원 종료

· Oracle Database Extensions for .NET 지원 종료

· Quality of Service Management 지원 종료

· Tradition Auditing 감사 지원 종료 (Unified Auditing 이 기본)

· config.sh 지원 종료 (gridSetup.sh 만 사용)

· OLS 테이블의 LABELS 열 지원 종료

· 32 비트 Oracle Database

· 고 가용성을위한 Oracle GoldenGate 복제 지원 종료

· 그리드 인프라 관리 저장소 (GIMR) 지원 종료

· 데이터 복구 어드바이저 (DRA) 지원 종료

· DBUA 및 수동 업그레이드 방법 지원 종료 (AutoUpgrade 만 사용권장)

· Oracle Real Application Testing을 통한 Oracle Data Masking and Subsetting 지원 종료

· Shared Grid Naming Sevice 옵션 지원 종료

· DBMS_AUDIT_MGMT.FLUSH_UNIFIED_AUDIT_TRAIL 프로시저 지원 종료

· AUDIT_TRAIL_PROPERTY 매개 변수 AUDIT_TRAIL_WRITE 모드 지원 종료

· CTSS 시간 동기화 서비스 지원 종료

· Oracle Connection Manager 매개 변수 (CMAN) 암호 액세스 지원 종료

· EUS (Enterprise User Security) 현재 사용자 데이터베이스 링크 지원 종료

· oracle.jdbc.rowset 패키지 지원 종료

· IBM AIX에서 ACFS 지원 종료

· RECOVER ... SNAPSHOT TIME 지원 종료

· Oracle ASM 필터 드라이버 (ASMFD) 지원 종료

2025. 12. 9. 14:23 오라클

Oracle AI 26ai Linux x86-64 on-premise 버전 출시예정!!

드디어 Oracle AI 26ai on premises 버전이 2026년 1월경 Release 되는 것으로 발표가 되었다.

Oracle AI Database 26ai coming soon for Linux x86-64 on-premises platforms | database

Oracle AI Database 26ai coming soon for Linux x86-64 on-premises platforms

Big news for our on‑premises community: Oracle AI Database 26ai Enterprise Edition for Linux x86‑64 will be released in January 2026 as part of the quarterly Release Update (version 23.26.1). Oracle Engineering has been hard at work building a new generation of database that architects AI and Data together, and delivers AI-native data management on all the leading cloud platforms. Oracle AI Database is already available as an Oracle‑managed service in Oracle Cloud Infrastructure, Azure, Google Cloud, and AWS, as well as on Oracle engineered systems. Now that we have delivered Oracle AI Database on all leading clouds, we are making it available for on‑premises Linux x86-64 platforms, giving you even more choice to simplify architectures, accelerate AI‑driven development, and meet your security and performance needs no matter where your data lives.

This much‑anticipated milestone brings to your data centers the full power of 26ai, which includes AI Vector Search, globally distributed database with RAFT‑based replication, in‑database SQL firewall, quantum-resistant encryption, True Cache, JSON Relational Duality, Apache Iceberg Lakehouse support, and hundreds of additional new features.

For highlights about key capabilities in Oracle AI Database 26ai, see this blog post or watch this video.

Please continue to refer to My Oracle Support (MOS) Doc ID: 742060.1 for the latest information about Oracle Database release and support schedules.

2025. 12. 3. 22:16 내가 읽은 책

그녀를 지키다 - 장 밥티스트 안드레아

2025. 11. 28. 09:54 오라클

23ai Hidden parameter 확인 (23.7 버전 기준)

23ai Hidden parameter 확인 (23.7 버전 기준)

일반 Parameter 포함 7206개

DBFIPS_140 FALSE

_4030_dump_bitvec 4095

_4031_dump_bitvec 67194879

_4031_dump_interval 300

_4031_max_dumps 100

_4031_sga_dump_interval 3600

_4031_sga_max_dumps 10

_AllowMultInsteadofDDLTrigger 0

_EnableDDLTtriggerTracing FALSE

_EnableShadowTypes FALSE

_ILM_FILTER_TIME 0

_ILM_FILTER_TIME_LOWER 0

_ILM_POLICY_NAME FALSE

_NUMA_bind_mode default

_NUMA_float_spawner FALSE

_NUMA_instance_mapping Not specified

_NUMA_pool_reservation_trace FALSE

_NUMA_pool_size Not specified

_PX_use_large_pool FALSE

_REMOVE_INACTIVE_STANDBY_TDE_MASTER_KEY FALSE

_REMOVE_STDBY_OLD_KEY_AFTER_CHECKPOINT_SCN TRUE

_STFForceTranslateOracleSQL FALSE

_STFTranslateDynamicSQL FALSE

_VIEW_DICTIONARY_ACCESSIBILITY FALSE

__asm_max_connected_clients 3

__bct_last_dba_buffer_size 0

__cnf 100

__data_transfer_cache_size 0

__datamemory_area_size 0

__db_16k_cache_xmem_size_metadata 0

__db_2k_cache_xmem_size_metadata 0

__db_32k_cache_xmem_size_metadata 0

__db_4k_cache_xmem_size_metadata 0

__db_8k_cache_xmem_size_metadata 0

__db_cache_size 2801795072

__db_cache_xmem_size_metadata 0

__db_keep_cache_xmem_size_metadata 0

__db_pmem_direct_map_size_metadata 0

__db_recycle_cache_xmem_size_metadata 0

__dg_broker_service_names

__inmemory_ext_roarea 0

__inmemory_ext_rwarea 0

__inmemory_size 0

__java_pool_size 0

__kstrc_qa_credentials

__large_pool_size 16777216

__latch_test_param 0

__maintenance_is_planned 0

__memoptimize_xmem_pool_size_metadata 0

__oracle_base /u01/app/oracle

__persistent_cl2_slave_size 0

__pga_aggregate_target 1241513984

__pre_update_rolling_rrp_compatibility

__previous_rolling_rrp_compatibility

__reload_lsnr 0

__rolling_list_int_param_spare1

__rolling_list_int_param_spare2

__rolling_list_string_param_spare3 default

__rolling_rrp_boolean_param_spare1 FALSE

__rolling_rrp_compatibility

__rolling_rrp_compatibility_homogeneity_check

__rolling_rrp_disabled

__rolling_rrp_exceptions

__rolling_rrp_int_spare1 0

__rolling_rrp_int_spare2 0

__rolling_rrp_intent_to_rollback FALSE

__rolling_rrp_last_enable_version 23.1.0

__rolling_rrp_previous_last_enable_version

__rolling_rrp_simulate_binary_rrp 0

__rolling_rrp_simulate_binary_rrp_with_cb 0

__rolling_rrp_simulate_one_off_rrp

__rolling_rrp_string_spare1

__rolling_rrp_string_spare2

__sess_template_test_attrs FALSE

__sga_current_size 0

__sga_target 3690987520

__shared_io_pool_size 134217728

__shared_pool_size 704643072

__streams_pool_size 0

__unified_pga_pool_size 0

__wait_test_param 0

_abort_on_mrp_crash FALSE

_abort_recovery_on_join FALSE

_ac_enable_dscn_in_rac FALSE

_ac_strict_SCN_check FALSE

_accept_versions

_aco_disable_options 0

_actgrp_spawn_offload FALSE

_active_dgpdb TRUE

_active_dgpdb_qscn_count 100

_active_instance_count 1024

_active_session_idle_limit 5

_active_session_legacy_behavior FALSE

_active_standby_fast_reconfiguration TRUE

_adaptive_direct_read TRUE

_adaptive_direct_write TRUE

_adaptive_fetch_enabled TRUE

_adaptive_log_file_sync_high_switch_freq_threshold 3

_adaptive_log_file_sync_poll_aggressiveness 0

_adaptive_log_file_sync_sampling_count 128

_adaptive_log_file_sync_sampling_time 3

_adaptive_log_file_sync_sched_delay_window 60

_adaptive_log_file_sync_use_polling_threshold 200

_adaptive_log_file_sync_use_postwait_threshold 50

_adaptive_log_file_sync_use_postwait_threshold_agi 1001

ng

_adaptive_scalable_log_writer_disable_worker_thres 50

hold

_adaptive_scalable_log_writer_enable_worker_aging 999900

_adaptive_scalable_log_writer_enable_worker_thresh 200

old

_adaptive_scalable_log_writer_evaluation_fraction 100

_adaptive_scalable_log_writer_evaluation_interval 15

_adaptive_scalable_log_writer_sampling_count 128

_adaptive_scalable_log_writer_sampling_time 3

_adaptive_window_consolidator_enabled TRUE

_add_col_optim_enabled TRUE

_add_nullable_column_with_default_optim TRUE

_add_stale_mv_to_dependency_list TRUE

_add_trim_for_nlssort TRUE

_addm_auto_actions_enabled TRUE

_addm_auto_enable TRUE

_addm_skiprules

_addm_version_check TRUE

_adg_adt_redirect_apply_lag_threshold 12000

_adg_adt_redirect_catchup_wait_time 12000

_adg_auto_close_pdb TRUE

_adg_count_beyond_limit 0

_adg_defer_segstat TRUE

_adg_distributed_lockmaster FALSE

_adg_influx_qscn_gap 0

_adg_instance_recovery TRUE

_adg_objectlock_attempts 2

_adg_objectlock_maxnum 1000

_adg_objectlock_timeout 0

_adg_parselock_timeout 0

_adg_parselock_timeout_sleep 100

_adg_redirect_upd_to_primary_max_retries 500

_adjust_literal_replacement FALSE

_adr_migrate_runonce TRUE

_advanced_index_compression_cmp_options 0

_advanced_index_compression_opt_options 0

_advanced_index_compression_options 0

_advanced_index_compression_options_value 0

_advanced_index_compression_recmp_crsz 10

_advanced_index_compression_recmp_cusz 90

_advanced_index_compression_recmp_nprg 10

_advanced_index_compression_trace 0

_advanced_index_compression_tst_options 0

_advanced_index_compression_umem_options 2147483647

_afd_disable_fence FALSE

_affected_row_threshold_for_dst_upgrade_using_dml 100

_affinity_on TRUE

_age_block_batch_timeout_ms 1000

_aged_out_cursor_cache_time 300

_aggregation_optimization_settings 0

_ahub_data_file_loc

_aiowait_timeouts 100

_alert_expiration 604800

_alert_message_cleanup 1

_alert_message_purge 1

_alert_post_background 1

_alert_segment_size 50

_alert_segment_textfile TRUE

_alert_segments_max 20

_all_shared_dblinks

_all_sync_restrict_list

_alloc_perm_as_free FALSE

_allocate_creation_order FALSE

_allocate_flashback_buffer FALSE

_allocation_update_interval 3

_allow_cell_smart_scan_attr TRUE

_allow_commutativity TRUE

_allow_compatibility_adv_w_grp FALSE

_allow_connected_user_dblink TRUE

_allow_convert_to_standby FALSE

_allow_cross_endian_dictionary FALSE

_allow_cross_version_ddl 0

_allow_ddl_in_fga_handler FALSE

_allow_drop_snapshot_standby_grsp FALSE

_allow_drop_ts_with_grp FALSE

_allow_error_simulation FALSE

_allow_fallback_to_dbkey FALSE

_allow_fga_mixed_mode FALSE

_allow_file_1_offline_error_1245 FALSE

_allow_imc_adaptive_grow TRUE

_allow_imc_adaptive_shrink TRUE

_allow_insert_with_update_check FALSE

_allow_level_without_connect_by FALSE

_allow_modify_lockdown FALSE

_allow_operator_access FALSE

_allow_privileged_session_dblink_conn FALSE

_allow_read_only_corruption FALSE

_allow_resetlogs_corruption FALSE

_allow_same_cdb_refresh_switchover TRUE

_allow_self_signed_cert FALSE

_allow_snr_rac FALSE

_allow_synonym_for_credential TRUE

_allow_sysosenv_context FALSE

_allow_system_wallet TRUE

_allow_terminal_recovery_corruption FALSE

_allow_traditional_audit_configuration FALSE

_allow_triggers_on_vpd_table FALSE

_allow_unenc_ts_without_tde_master_key FALSE

_allow_user$_col_update NONE

_allow_xdb_anonymous_logon FALSE

_allowed_pvf_owners

_alter_adg_redirect_behavior none

_alter_table_modify_column_nop_flags 1

_alter_upgrade_signature_only FALSE

_alternate_iot_leaf_block_split_points TRUE

_always_anti_join CHOOSE

_always_semi_join CHOOSE

_always_star_transformation FALSE

_always_vector_transformation FALSE

_analyze_comprehensive FALSE

_and_pruning_enabled TRUE

_ansi_join_mv_rewrite_enabled TRUE

_app_container_debug 0

_app_default_containers FALSE

_app_ignore_errors TRUE

_app_replay_silent_errors FALSE

_appcont_error_convert ON

_application_purge_enabled TRUE

_application_script FALSE

_apppdb_multi_slave_sync FALSE

_appqos_cdb_setting 0

_appqos_po_multiplier 1000

_appqos_qt 10

_approx_cnt_distinct_gby_pushdown choose

_approx_cnt_distinct_optimization 0

_approx_perc_sampling_err_rate 2

_approx_percentile_optimization 0

_aps_flush_enabled FALSE

_apx_root_directory APX

_aq_Txn_ht_sz 1024

_aq_addpt_batch_size 1

_aq_bufop_svc_create 1

_aq_deq_flowcontrol 0

_aq_dly_bkt 60

_aq_dq_prefetch_Siz 5

_aq_dqblocks_in_cache 0

_aq_droppt_batch_size 5

_aq_free_list_pools 10

_aq_init_shards 5

_aq_ipc_max_slave 10

_aq_latency_absolute_threshold 300

_aq_latency_relative_threshold 100

_aq_lb_cycle 120

_aq_lb_garbage_col_interval 600

_aq_lb_stats_collect_cycle 45

_aq_lb_subht_bkt_ltch 32

_aq_lb_subht_elm_ltch 128

_aq_lookback_size 60

_aq_max_pdb_close_msg 1

_aq_max_scan_delay 1500

_aq_opt_background_enabled TRUE

_aq_opt_enabled TRUE

_aq_opt_fudge_factor 500

_aq_opt_list_oper_latches 8

_aq_opt_min_evict_memory 0

_aq_opt_preevict_dop 3

_aq_opt_prefetch_dop 3

_aq_opt_prefetch_horizon 60

_aq_opt_stat_window 21600

_aq_opt_stop_stat FALSE

_aq_pt_processes 10

_aq_pt_shrink_frequency 60

_aq_pt_statistics_window 60

_aq_qt_prefetch_Size 5

_aq_queue_global_service

_aq_retry_timeouts 0

_aq_scramble_deq 0

_aq_scrambled_deqlog 1

_aq_shard_bitmap_child_latches 32

_aq_shard_child_latches 512

_aq_shard_prty_latches 16

_aq_shard_retry_child_latches 32

_aq_shard_sub_child_Elem_latches 1024

_aq_shard_sub_child_latches 512

_aq_shard_txn_child_latches 128

_aq_stop_backgrounds FALSE

_aq_streaming_threshold 10485760

_aq_subshard_Size 20000

_aq_subshards_per_dqpartition 1

_aq_subshards_per_qpartition 1

_aq_tm_deqcountinterval 0

_aq_tm_processes_dump_interval 12

_aq_tm_scanlimit 0

_aq_tm_statistics_duration 0

_aq_truncpt_batch_size 1

_aq_uncached_stats 0

_aq_x_mode 1

_aq_x_msg_size 32768

_aqsharded_cache_limit 0

_aqsharded_cache_policy_lowmem 0

_aqsharded_cached_hint 0

_aqsharded_enq_fresh_ptn_reload TRUE

_aqsharded_lowmem_timeout 1000

_aqsharded_reload_tune 2

_arch_comp_dbg_scan 0

_arch_comp_dec_block_check_dump 1

_arch_compress_checksums FALSE

_arch_compression TRUE

_arch_io_slaves 0

_array_cdb_view_enabled TRUE

_array_update_vector_read_enabled FALSE

_ash_disk_filter_ratio 10

_ash_disk_write_enable TRUE

_ash_dummy_test_param 0

_ash_eflush_trigger 66

_ash_enable TRUE

_ash_min_mmnl_dump 90

_ash_progressive_flush_interval 300

_ash_sample_all FALSE

_ash_sampling_interval 1000

_ash_size 1048618

_asm_access auto

_asm_access_assume_local FALSE

_asm_acd_chunks 1

_asm_admin_with_sysdba FALSE

_asm_allow_appliance_dropdisk_noforce FALSE

_asm_allow_appliance_offlineonline FALSE

_asm_allow_dangerous_unprotected_volumes FALSE

_asm_allow_dgname_special_chars FALSE

_asm_allow_foreign_siteguids

_asm_allow_lvm_resilvering TRUE

_asm_allow_older_clients FALSE

_asm_allow_only_raw_disks TRUE

_asm_allow_prepare_split TRUE

_asm_allow_small_memory_target FALSE

_asm_allow_system_alias_rename FALSE

_asm_allow_unsafe_reconnect TRUE

_asm_allowdegeneratemounts FALSE

_asm_appliance_config_file

_asm_appliance_disable_fg_check FALSE

_asm_appliance_ignore_oak FALSE

_asm_appliance_slot_from_path FALSE

_asm_asmb_exa_rcvto 30

_asm_asmb_max_wait_timeout 6

_asm_asmb_rcvto 10

_asm_async_scrub_reap_wait 100000

_asm_ate_conversion_batch_size 1024

_asm_audit_sp_param

_asm_ausize 1048576

_asm_auto_online_interval

_asm_automatic_rezone TRUE

_asm_avoid_pst_scans TRUE

_asm_bdbmr_max_ent_inprgrs 2000

_asm_blksize 4096

_asm_br_listener_port 51521

_asm_brfuzz_ios_lsnrport 0

_asm_buffer_overlap_tracer FALSE

_asm_cancel_alert_time 600

_asm_cancel_delta 75000

_asm_cclient_cleanup_timeout 300

_asm_check_for_misbehaving_cf_clients FALSE

_asm_checksum_migration_chunk_size 128

_asm_compatibility 23.1

_asm_dba_batch 500000

_asm_dba_spcchk_thld 100000

_asm_dba_threshold 0

_asm_dbmsdg_nohdrchk FALSE

_asm_dependency_under_cfenqueue TRUE

_asm_diag_dead_clients FALSE

_asm_direct_con_expire_time 120

_asm_disable_amdu_dump FALSE

_asm_disable_async_msgs FALSE

_asm_disable_dangerous_failgroup_checking FALSE

_asm_disable_exadata_hard_appliance_check FALSE

_asm_disable_failgroup_count_checking FALSE

_asm_disable_failgroup_size_checking FALSE

_asm_disable_multiple_instance_check FALSE

_asm_disable_patch_compat FALSE

_asm_disable_proact_client_cleanup FALSE

_asm_disable_profilediscovery FALSE

_asm_disable_pstcard FALSE

_asm_disable_request_tracer TRUE

_asm_disable_smr_creation FALSE

_asm_disable_ufg_dump FALSE

_asm_disable_ufgmemberkill FALSE

_asm_disable_vtoc_check FALSE

_asm_disable_vxn_map_messages FALSE

_asm_disk_repair_time 14400

_asm_diskerr_traces 2

_asm_diskgroup_renew_timeout 20

_asm_diskgroups2

_asm_diskgroups3

_asm_diskgroups4

_asm_dump_split_pw 10

_asm_dynamic_timeout_interval 20

_asm_emulate_nfs_disk FALSE

_asm_emulmax 10000

_asm_emultimeout 0

_asm_enable_batch_scrub TRUE

_asm_enable_kfios FALSE

_asm_enable_kfks FALSE

_asm_enable_lostwrite_scrub TRUE

_asm_enable_map_share TRUE

_asm_enable_multiple_asmb TRUE

_asm_enable_parity_scrub FALSE

_asm_enable_parityfile_creation TRUE

_asm_enable_pstreloc_on_rm FALSE

_asm_enable_repair_lostwrite_scrub FALSE

_asm_enable_vfreloc_on_rm FALSE

_asm_enable_xrov FALSE

_asm_evenread 2

_asm_evenread_alpha 0

_asm_evenread_alpha2 0

_asm_evenread_faststart 0

_asm_fail_random_rx FALSE

_asm_fd_cln_idle_sess_twait 60000000

_asm_fd_cln_on_fg TRUE

_asm_fob_tac_frequency 9

_asm_force_parity_extent_check FALSE

_asm_force_paritycheck_rebalance FALSE

_asm_force_quiesce FALSE

_asm_force_vam FALSE

_asm_frag_threshold 50

_asm_global_dump_level 267

_asm_hard_check TRUE

_asm_hbeatiowait 120

_asm_hbeatwaitquantum 2

_asm_healthcheck_timeout 180

_asm_identify_advisory_locks 2

_asm_idn_processes 0

_asm_imbalance_tolerance 3

_asm_instlock_quota 0

_asm_ios_network_domains 0

_asm_ios_network_processes 0

_asm_iosconnect_timeout 0

_asm_iosfailover_freq 3

_asm_iosfailover_timeout 5

_asm_iostat_latch_count 31

_asm_iowp_max_async 0

_asm_kfdpevent 0

_asm_kill_unresponsive_clients TRUE

_asm_libraries ufs

_asm_log_scale_rebalance FALSE

_asm_lsod_bucket_size 67

_asm_max_aux_cods 5

_asm_max_clients 1000

_asm_max_cod_strides 10

_asm_max_connected_clients 3

_asm_max_kfsg_free_heap_perc 10

_asm_max_kfsg_free_heap_size 524288000

_asm_max_occupied 90

_asm_max_parallelios 256

_asm_max_redo_buffer_size 2097152

_asm_maxio 1048576

_asm_min_compatibility 19.0

_asm_min_occupied 50

_asm_netp_factor 0

_asm_netp_iosize 0

_asm_network_timeout 1

_asm_networks

_asm_no_shared_maplock FALSE

_asm_node_number

_asm_node_site_guid

_asm_nodekill_escalate_time 180

_asm_noevenread_diskgroups

_asm_oda_type

_asm_odapremchk TRUE

_asm_offline_wait_timeout 300

_asm_offload_all FALSE

_asm_ownerid_trace_timeout 3600

_asm_partner_target_disk_part 8

_asm_partner_target_fg_rel 4

_asm_preopen_mincnt 100

_asm_preopen_workers 4

_asm_primary_load 1

_asm_primary_load_cycles TRUE

_asm_procs_trace_diskerr 5

_asm_proxy_online_restart 0

_asm_proxy_startwait 60

_asm_pst_rsinfo 0

_asm_pstonpartners TRUE

_asm_quorum_hb TRUE

_asm_random_zone FALSE

_asm_read_cancel DYNAMIC

_asm_read_cancel_back_out 5000

_asm_read_cancel_dynamic_delta 20

_asm_read_cancel_timeout_limit 15000

_asm_read_cancel_timeout_min 5000

_asm_rebalance_estimates_process TRUE

_asm_rebalance_plan_size 120

_asm_rebalance_rate_alpha 0

_asm_rebalance_rate_alpha2 0

_asm_rebalance_rate_faststart 10

_asm_rebalance_rate_interval 9000

_asm_rebalance_space_errors 1000

_asm_reloc_cic FALSE

_asm_reloc_restart_timeout 600

_asm_relocation_async_lock_count 128

_asm_relocation_ignore_hard_failure 0

_asm_relocation_scheme alloc_p2 alloc_s3 reb_p2 reb_s1 bal_p2 bal_s3 prep

_p2 prep_s3

_asm_relocation_trace FALSE

_asm_remote_client_timeout 300

_asm_repairquantum 60

_asm_reserve_slaves TRUE

_asm_resyncCkpt 6000

_asm_root_directory ASM

_asm_runtime_capability_volume_support FALSE

_asm_scrub_async TRUE

_asm_scrub_disable_cod FALSE

_asm_scrub_limit AUTO

_asm_scrub_max_cod_wait 5

_asm_scrub_strict FALSE

_asm_scrub_unmatched_dba 1024

_asm_secondary_load 10000

_asm_secondary_load_cycles FALSE

_asm_serialize_volume_rebalance FALSE

_asm_shadow_cycle 3

_asm_shared_pool_latch_timeout 30

_asm_showpdb_asmtbl FALSE

_asm_skip_cod_recovery_diskgroups

_asm_skip_dbfile_ios FALSE

_asm_skip_diskval_check FALSE

_asm_skip_rename_check FALSE

_asm_skip_resize_check FALSE

_asm_slow_client_timeout_percentage 50

_asm_ssd_max_timeout_limit 2400

_asm_storagemaysplit FALSE

_asm_stripesize 131072

_asm_stripewidth 8

_asm_sync_rebalance FALSE

_asm_tcp_user_timeout 1

_asm_trace_limit_timeout 30000

_asm_ufg_nw_wait_timeout 10

_asm_usd_batch 64

_asm_wait_time 18

_asm_write_badfdata_in_contentcheck FALSE

_asm_write_cancel AUTO

_asm_write_cancel_dynamic_delta 30

_asm_write_cancel_timeout_limit 90000

_asm_write_cancel_timeout_min 15000

_asm_write_cancel_timeout_percentage 30

_asm_xrov_cachelgio 1

_asm_xrov_nstats 0

_asm_xrov_nvios 24

_asm_xrov_rsnmod 2

_asm_xrov_single FALSE

_asm_zero_power_limit

_asmsid asm

_assert_encrypted_tablespace_blocks TRUE

_assert_invalidation 0

_assert_single_current_buffer FALSE

_assm_auto_tracing_threshold 0

_assm_default TRUE

_assm_examination_blocks_threshold 8196

_assm_examination_enable_sla FALSE

_assm_examination_time_threshold 60

_assm_force_fetchmeta FALSE

_assm_high_gsp_threshold 11024

_assm_l1cleanout_throttle_time 3

_assm_latency_sampling_frequency 0

_assm_low_gsp_threshold 10000

_assm_segment_extension_percent 100

_assm_segment_repair_bg TRUE

_assm_segment_repair_fg 0

_assm_segment_repair_maxblks 4294967294

_assm_segment_repair_timelimit 60

_assm_space_cache_hb_expire 3

_assm_space_cache_max_segments 1024

_assm_test_force_rej 0

_assm_test_force_rej2 0

_assm_test_reentrant_gsp FALSE

_async_recovery_claims TRUE

_async_recovery_reads TRUE

_async_rta_broadcast FALSE

_async_scn_sync OFF

_async_ts_threshold 1

_atp_block_size_default TRUE

_audit_operator_access FALSE

_auto_assign_cg_for_sessions FALSE

_auto_bmr enabled

_auto_bmr_bg_time 3600

_auto_bmr_fc_time 60

_auto_bmr_file_header TRUE

_auto_bmr_max_rowno 1024

_auto_bmr_noretry_window 1800

_auto_bmr_pub_timeout 10

_auto_bmr_req_timeout 60

_auto_bmr_sess_threshold 30

_auto_bmr_sys_threshold 100

_auto_clustering FALSE

_auto_clustering_sqlset

_auto_db_lost_write_protect_fsfo_lag_limit_percent 67

_auto_db_lost_write_protect_max_lag_secs 60

_auto_dismount_on_pdb_close FALSE

_auto_export_preplugin_backup TRUE

_auto_im_batch_size 10

_auto_im_cache_join_opt FALSE

_auto_im_join_group FALSE

_auto_im_max_perf_candidates 3

_auto_im_monitor_interval 1440

_auto_im_optimized_arithmetic FALSE

_auto_im_perf_threshold 10

_auto_im_play_area 10

_auto_im_rac_enabled TRUE

_auto_im_task_mode 0

_auto_im_vector_gby_opt FALSE

_auto_manage_asm_diskgroup_power_limit_max 32

_auto_manage_asm_diskgroup_power_limit_min 1

_auto_manage_enable_offline_check TRUE

_auto_manage_enable_smart_rebalance TRUE

_auto_manage_exadata_disks TRUE

_auto_manage_infreq_tout 0

_auto_manage_ioctl_bufsz 8192

_auto_manage_max_num_cells_offline 65535

_auto_manage_max_online_tries 3

_auto_manage_num_pipe_msgs 1000

_auto_manage_num_tries 2

_auto_manage_online_tries_expire_time 86400

_auto_manage_power_limit_adjustment_disabled FALSE

_auto_manage_remount_eligible_dg TRUE

_auto_manage_smart_rebalance_grace_period_in_min 0

_auto_manage_smart_rebalance_space_threshold 0

_auto_mv_enabled FALSE

_auto_rcv_pdb_open 1

_auto_rekey_during_mrcv TRUE

_auto_temp_shrink_pdb_floor 0

_autocomp_inact_pct 98

_autocomp_move_max_mb 128

_autoconf_mv_rewrite_metadata TRUE

_automatic_maintenance_test 0

_automemory_broker_interval 3

_autoptn_config

_autoptn_costing FALSE

_autoptn_flags 0

_autoptn_translate_table_name

_autoptn_workload_id 0

_autosts_capture_control 3

_autosts_long_interval 0

_autosts_retention_interval 31

_autosts_short_interval 300

_autotask_max_window 480

_autotask_min_window 15

_autotask_test_action 0

_autotask_test_name N/A

_autotbs_management_enabled FALSE

_autotbs_quota_override FALSE

_autotune_gtx_idle_time 600

_autotune_gtx_interval 5

_autotune_gtx_threshold 60

_aux_dfc_keep_time 1440

_aux_storage_size 0

_available_core_count 0

_avoid_scn_growth 1

_awr_adg_flush_method SYSTEM_DEFINED

_awr_cdbperf_threshold 21

_awr_colored_app_enabled FALSE

_awr_corrupt_mode FALSE

_awr_data_masking FALSE

_awr_disabled_flush_tables

_awr_disabled_purge_tables

_awr_enable_pdb_snapshots TRUE

_awr_flush_threshold_metrics TRUE

_awr_flush_workload_metrics FALSE

_awr_hub_autoimp_inline FALSE

_awr_hub_consumer_group ORA$AUTOTASK

_awr_hub_num_conc_imp 2

_awr_incremental_flush_enabled TRUE

_awr_max_registrations 1024

_awr_metrics_use_mmnl FALSE

_awr_mmon_cpuusage TRUE

_awr_mmon_deep_purge_all_expired FALSE

_awr_mmon_deep_purge_extent 7

_awr_mmon_deep_purge_interval 7

_awr_mmon_deep_purge_numrows 5000

_awr_overflow_enabled FALSE

_awr_partition_interval 0

_awr_pdb_registration_enabled FALSE

_awr_report_gen_method LEGACY

_awr_restrict_mode FALSE

_awr_snapshot_level BESTFIT

_awr_sql_child_limit 200

_awr_sqltext_redaction FALSE

_awr_warehouse_enabled TRUE

_awrextr_include_sqlmon FALSE

_b_tree_bitmap_plans TRUE

_ba_cf_trace_buffer_size 131072

_ba_container_filesystem_ausize 4194304

_ba_max_containers 0

_ba_max_groups 0

_ba_max_seg_bytes 4000

_ba_timeouts_enabled TRUE

_background_process_opts 0

_backup_align_write_io TRUE

_backup_appliance_enabled FALSE

_backup_automatic_retry 10

_backup_block0 default

_backup_bool_spare1 FALSE

_backup_bool_spare2 FALSE

_backup_bool_spare3 FALSE

_backup_bool_spare4 FALSE

_backup_compress FALSE

_backup_disk_bufcnt 0

_backup_disk_bufsz 0

_backup_disk_io_slaves 0

_backup_dynamic_buffers TRUE

_backup_encrypt_opt_mode 4294967294

_backup_file_bufcnt 0

_backup_file_bufsz 0

_backup_int_spare1 4294967294

_backup_int_spare2 4294967294

_backup_int_spare3 4294967294

_backup_int_spare4 4294967294

_backup_interrupt_wait_time 1000

_backup_io_pool_size 1048576

_backup_kgc_bz2_bufsz 0

_backup_kgc_bz2_niters 0

_backup_kgc_bz2_type 0

_backup_kgc_bzip2_blksiz 9

_backup_kgc_lzo_bufsz 262144

_backup_kgc_medium_scheme DEFAULT

_backup_kgc_scheme ZLIB

_backup_kgc_zlib_complevel 1

_backup_kgc_zlib_memlevel 8

_backup_kgc_zlib_windowbits 15

_backup_kgc_zstd_bufsz 262144

_backup_kgc_zstd_complevel 3

_backup_kgc_zstd_high_complevel 14

_backup_ksfq_bufcnt 0

_backup_ksfq_bufmem_max 268435456

_backup_ksfq_bufsz 0

_backup_max_gap_size 4294967294

_backup_max_wallet_session 50

_backup_min_ct_unused_optim 2097152

_backup_seq_bufcnt 0

_backup_seq_bufsz 0

_backup_text_spare1

_backup_text_spare2

_backup_text_spare3

_backup_text_spare4

_bct_auto_ctf_shrink FALSE

_bct_bitmaps_per_file 8

_bct_buffer_allocation_max 1073741824

_bct_buffer_allocation_min_extents 1

_bct_buffer_allocation_size 2097152

_bct_chunk_size 0

_bct_crash_reserve_size 262144

_bct_dba_buffer_reap_threshold 2000

_bct_ext_alo_count 320

_bct_ext_min_count 320

_bct_file_block_size 0

_bct_file_extent_size 0

_bct_fixtab_file

_bct_health_check_interval 0

_bct_imt_suppress_charset_validation 3

_bct_min_switch_freq 43200

_bct_mrp_timeout 5

_bct_public_dba_buffer_dynresize 2

_bct_public_dba_buffer_dynresize_delay 3600

_bct_public_dba_buffer_maxsize 0

_bct_public_dba_buffer_size 0

_bct_wait_before_trace_dump 120

_bctab_max_system_chains 1024

_bctab_optimize_commit_performance FALSE

_beirut_timeout_minutes 10

_bequeath_via_broker FALSE

_bg_dgpdb_rcv_parallelism 0

_bg_spawn_diag_opts 0

_big_scn_test_mode 2

_bigdata_external_table TRUE

_bigdata_offload_flag FALSE

_bigram_dependency_percentage 5

_bind_undotbs DISABLED

_bitmap_or_improvement_enabled TRUE

_block_change_tracking_file

_block_corruption_track_limit 1000

_block_dump_assert FALSE

_block_level_offload_high_lat_thresh 40000

_block_sample_readahead_prob_threshold 10

_blockchainHeapSize 0

_blockchainTracing 0

_blockchain_forced_off NOT_SET

_blockchain_immutable_table

_blockchain_txn_apis_enabled TRUE

_blockchain_txn_test_lvl 0

_blockhm_flush_period 3600

_blocking_sess_graph_cache_size

_blocks_per_cache_server 1

_bloom_extent_size 0

_bloom_filter_debug 0

_bloom_filter_enabled TRUE

_bloom_filter_multi_bit FALSE

_bloom_filter_ratio 35

_bloom_filter_setops_enabled TRUE

_bloom_filter_size 0

_bloom_folding_density 16

_bloom_folding_enabled TRUE

_bloom_folding_min 0

_bloom_max_size 262144

_bloom_max_wait_time 50

_bloom_minmax_enabled TRUE

_bloom_predicate_enabled TRUE

_bloom_predicate_offload TRUE

_bloom_pruning_enabled TRUE

_bloom_pruning_setops_enabled TRUE

_bloom_pushing_folding_density 4

_bloom_pushing_max 512

_bloom_pushing_total_max 20971520

_bloom_rm_filter FALSE

_bloom_serial_filter ON

_bloom_sm_enabled TRUE

_bloom_use_shared_pool FALSE

_bloom_wait_on_rac FALSE

_boc_mode AUTO

_boc_rdma_wait_time 0

_bps_sanity_checks FALSE

_branch_tagging TRUE

_broadcast_scn_mode 1

_broadcast_scn_wait_timeout 10

_broker_imc_max_utilstep 95

_bsln_adaptive_thresholds_enabled TRUE

_bt_mmv_query_rewrite_enabled TRUE

_buddy_instance 1

_buddy_instance_num_read_buffers 4

_buddy_instance_scan_phase_threshold 3

_buddy_instance_start_rba_timeout 9

_buffer_busy_wait_timeout 100

_buffer_requests_to_drain 5

_buffered_message_spill_age 300

_buffered_publisher_flow_control_threshold 0

_bufq_stop_flow_control FALSE

_build_deferred_mv_skipping_mvlog_update TRUE

_bump_highwater_mark_count 0

_bwr_for_flushed_pi TRUE

_bypass_sensitive_context FALSE

_bypass_srl_for_so_eor FALSE

_bypass_xplatform_error FALSE

_c3_external_scn_rejection_threshold_hours 4464

_cache_fusion_pipelined_updates TRUE

_cache_fusion_pipelined_updates_enable

_cache_lobs_pga_limit 75

_cache_orl_during_open ALL

_cache_stats_monitor FALSE

_capability_simulate

_capture_buffer_size 65536

_capture_pgadep 0

_capture_publisher_flow_control_threshold 0

_case_sensitive_logon TRUE

_catalog_foreign_restore FALSE

_catalog_soft_assert_diag FALSE

_causal_standby_wait_timeout 20

_cdb_compatible TRUE

_cdb_cross_container 65535

_cdb_disable_pdb_limit FALSE

_cdb_fleet_sync_timeout 10

_cdb_init_batch_size 100

_cdb_port 0

_cdb_rac_affinity TRUE

_cdb_special_old_xplan FALSE

_cdb_spfile_inherit FALSE

_cdb_svlt_use_tcps FALSE

_cdb_view_no_skip_migrate FALSE

_cdb_view_no_skip_restricted FALSE

_cdb_view_parallel_degree 65535

_cdb_view_prefetch_batch_size 200

_cdb_view_rc_shelflife 30

_cdb_view_recursive_px_enabled TRUE

_cdb_view_serial_ok FALSE

_cdc_subscription_owner

_cdmp_diagnostic_level 2

_cell_fast_file_create TRUE

_cell_fast_file_restore TRUE

_cell_file_format_chunk_size 0

_cell_index_scan_enabled TRUE

_cell_iot_scan_enabled TRUE

_cell_materialize_all_expressions FALSE

_cell_materialize_virtual_columns TRUE

_cell_metadata_compression AUTO

_cell_object_expiration_hours 24

_cell_offload_capabilities_enabled 1

_cell_offload_complex_processing TRUE

_cell_offload_expressions TRUE

_cell_offload_grand_total TRUE

_cell_offload_hybrid_processing TRUE

_cell_offload_hybridcolumnar TRUE

_cell_offload_predicate_reordering_enabled FALSE

_cell_offload_sys_context TRUE

_cell_offload_timezone TRUE

_cell_offload_vector TRUE

_cell_offload_vector_groupby TRUE

_cell_offload_vector_groupby_external TRUE

_cell_offload_vector_groupby_fact_key TRUE

_cell_offload_vector_groupby_force FALSE

_cell_offload_vector_groupby_withnojoin TRUE

_cell_offload_virtual_columns TRUE

_cell_range_scan_enabled TRUE

_cell_storidx_minmax_enabled TRUE

_cell_storidx_mode EVA

_cell_trace_size 0

_cellcache_clause_default

_cellcache_default_flags 2

_cellcache_default_new FALSE

_cgs_allgroup_poll_time 20000

_cgs_big_group_enabled FALSE

_cgs_clscevents_dumpinterval 600

_cgs_combine_css_events 31

_cgs_comm_readiness_check 1

_cgs_dball_group_registration local

_cgs_dbgroup_poll_time 600

_cgs_health_check_in_reconfig FALSE

_cgs_memberkill_from_rim_instance FALSE

_cgs_msg_batch_size 4096

_cgs_msg_batching TRUE

_cgs_node_kill_escalation TRUE

_cgs_node_kill_escalation_wait 0

_cgs_os_level_connection_check 1

_cgs_os_level_connection_dynamicthread TRUE

_cgs_os_level_connection_reqno 0

_cgs_publish_netinfo_collect_event_chm rcfg-half-timeout,rcfg-timeout,rcfg-done,idleconn-

half-timeout,idleconn-timeout-imr,idleconn-cln,rcf

g-begin,rcfg-pngchkdone,rcfg-memchg

_cgs_publish_netinfo_collect_event_chmjf TRUE

_cgs_publish_netinfo_collect_event_chmjf_batchsz 0

_cgs_publish_netinfo_collect_event_haip TRUE

_cgs_query_net_interface SCLSI

_cgs_reconfig_extra_wait 3

_cgs_reconfig_poll_time 20

_cgs_reconfig_timeout 0

_cgs_send_timeout 300

_cgs_support_rim_disc TRUE

_cgs_ticket_sendback 50

_cgs_tickets 1000

_cgs_zombie_member_kill_wait 20

_change_vector_buffers 1

_change_vector_read_sample_ratio 0

_check_block_after_checksum FALSE

_check_block_new_invariant_for_flashback FALSE

_check_column_length TRUE

_check_pdbid_in_redo FALSE

_check_ts_threshold 0

_child_read_ahead_dba_check FALSE

_chunk_pruning_enabled TRUE

_cleanout_shrcur_buffers TRUE

_cleanup_file_copy TRUE

_cleanup_rollback_entries 100

_cleanup_timeout 150

_cleanup_timeout_flags 0

_clear_buffer_before_reuse FALSE

_clear_preserved_buffers TRUE

_cli_cachebktalloc 100

_client_enable_auto_unregister FALSE

_client_features_tracking_enable TRUE

_client_ntfn_cleanup_interval 2400

_client_ntfn_max_cleanup_interval 7200

_client_ntfn_pinginterval 75

_client_ntfn_pingretries 6

_client_ntfn_pingtimeout 30000

_client_result_cache_bypass FALSE

_client_result_cache_ramthreshold

_client_result_set_threshold

_client_tstz_error_check TRUE

_clone_during_split TRUE

_clone_one_pdb_recovery FALSE

_close_cached_open_cursors FALSE

_close_deq_by_cond_curs FALSE

_cloud_domain

_cloud_mandatory_profile_setup FALSE

_cloud_name

_cloud_operator_user

_cloud_service_sim 0

_cloud_service_type

_cloud_service_version

_cloud_table_commit_time_limit 0

_cloud_trace 0

_cloud_trace_bucket_fill_percent 50

_cloud_trace_bucket_size 10485760

_cloud_trace_temp_table

_cloudops_common_users

_cloudops_sensitive_masking OFF

_cloudsql_offload_enabled FALSE

_cluster_database_instances 1

_cluster_flash_cache_slave_file

_cluster_flash_cache_slave_size 0

_cluster_instances_number 4

_cluster_library clss

_clusterwide_global_transactions TRUE

_collapse_wait_history FALSE

_collect_tempundo_stats TRUE

_collect_undo_stats TRUE

_column_compression_factor 0

_column_elimination_off FALSE

_column_level_stats OFF

_column_stats_flush_interval 60

_column_stats_max_entries_per_stat 5

_column_stats_mem_limit 10

_column_tracking_level 53

_common_data_view_enabled TRUE

_common_directory_access ALLOW

_common_user_prefix C##

_compilation_call_heap_extent_size 16384

_complex_view_merging TRUE

_component_timing

_composite_interval_partition_creation_opt_enabled TRUE

_compression_above_cache 0

_compression_advisor 0

_compression_chain 90

_compression_compatibility 23.6.0

_con_map_sql_enforcement TRUE

_con_number_reuse_threshold 2147483647

_concurrency_chosen 10

_connect_by_use_union_all TRUE

_connect_string_settings_after_logon_triggers 0

_connect_string_settings_unalterable 0

_connection_broker_error_new_limit 100

_connection_broker_handout_accept FALSE

_connection_broker_host localhost

_connstr_test_param 0

_consensus_follower_election_timeout 12000

_consensus_leader_heartbeat_interval 6000

_consensus_leader_maximum_heartbeats

_consensus_queue_maximum_elements 10

_consensus_slaves_maximum_count 5

_containers_dop_use_remote FALSE

_containers_multiple_ptn_key TRUE

_controlfile_auto_convert_behaviour AUTO_CONVERT

_controlfile_autobackup_delay 300

_controlfile_backup_copy_check TRUE

_controlfile_block_corruption_keep_records 4294967294

_controlfile_block_size 0

_controlfile_cache_bpb 4

_controlfile_cache_bpp 32

_controlfile_cache_recvrbsz 4096

_controlfile_cache_sendrbsz 4096

_controlfile_cache_size 8388608

_controlfile_cache_timer 600

_controlfile_cell_flash_caching 3

_controlfile_enable_rdma_read TRUE

_controlfile_enqueue_dump FALSE

_controlfile_enqueue_holding_time 120

_controlfile_enqueue_holding_time_tracking_size 0

_controlfile_enqueue_timeout 900

_controlfile_section_init_size

_controlfile_section_max_expand

_controlfile_split_brain_check FALSE

_controlfile_update_check LOW

_controlfile_validate_on_search FALSE

_controlfile_verify_on_mount FALSE

_convert_set_to_join FALSE

_coord_message_buffer 0

_corrupted_rollback_segments

_cost_equality_semi_join TRUE

_cp_del_free_sess TRUE

_cp_del_free_sess_limit_secs 1

_cp_num_hash_latches

_cpu_count_startup 0

_cpu_eff_thread_multiplier

_cpu_to_io 0

_cpu_util_adj_force 1

_cpu_util_adj_target 0

_cputime_limit_parallel_fptr 60

_cr_grant_global_role TRUE

_cr_grant_local_role AUTO

_cr_grant_only FALSE

_cr_multiblock_grant_only FALSE

_cr_rollbacks 0

_cr_server_log_flush TRUE

_cr_trc_buf_size 8192

_crash_domain_on_exception 0

_create_idx_from_constraint FALSE

_create_pdb_disable_mirror_reads FALSE

_create_pdb_flashback_barrier FALSE

_create_stat_segment 0

_create_table_in_any_cluster FALSE

_cross_con_collection TRUE

_cross_con_remove_pushed_preds FALSE

_cross_con_row_count FALSE

_cross_region_refclone TRUE

_crs_2phase bypass

_cstats_enabled FALSE

_ctas_numfrags_hint 0

_ctc_no_pdb_shrink_check 0

_ctex_fk_copy_mode 1

_cu_row_locking 0

_current_session_at_dbtimezone FALSE

_current_time_at_dbtimezone FALSE

_cursor_bind_capture_area_size 400

_cursor_bind_capture_interval 900

_cursor_cache_time 900

_cursor_db_buffers_pinned 1051

_cursor_diagnostic_node_agedout_count 100

_cursor_features_enabled 2

_cursor_obsolete_threshold 8192

_cursor_plan_enabled TRUE

_cursor_plan_hash_version 1

_cursor_plan_unparse_enabled TRUE

_cursor_reload_failure_threshold 20

_cursor_runtimeheap_memlimit 5242880

_cursor_stats_enabled TRUE

_cursor_stats_purge_threshold 0

_cvw_enable_weak_checking TRUE

_cvw_examine_tables_in_from_list_subqry TRUE

_data_access_stats FALSE

_data_access_stats_depth 0

_data_guard_redo_statistics 31

_data_guard_val_redo 65537

_data_link_remote FALSE

_data_transfer_cache_bc_perc_x100 500

_data_warehousing_scan_buffers TRUE

_data_warehousing_scan_flash_buffers FALSE

_data_warehousing_serial_scan TRUE

_database_role PRIMARY

_datafile_cow FALSE

_datafile_create_min_wait_time 0

_datafile_create_wait_time 0

_datafile_open_errors_crash_instance TRUE

_datafile_write_errors_crash_instance TRUE

_datamemory_area_size 0

_datamemory_favor_empty_granules_for_shrink 2

_datapump_bypass_tstz_check FALSE

_datapump_compressbas_buffer_size 0

_datapump_conv_pga_lim 0

_datapump_gather_stats_on_load FALSE

_datapump_hide_cdb_warning FALSE

_datapump_inherit_svcname TRUE

_datapump_metadata_buffer_size 131072

_datapump_net_transfer_size 0

_datapump_tabledata_buffer_size 262144

_db_16k_cache_xmem_size 0

_db_16k_flash_cache_file

_db_16k_flash_cache_size 0

_db_2k_cache_xmem_size 0

_db_2k_flash_cache_file

_db_2k_flash_cache_size 0

_db_32k_cache_xmem_size 0

_db_32k_flash_cache_file

_db_32k_flash_cache_size 0

_db_4k_cache_xmem_size 0

_db_4k_flash_cache_file

_db_4k_flash_cache_size 0

_db_8k_cache_xmem_size 0

_db_8k_flash_cache_file

_db_8k_flash_cache_size 0

_db_active_prewarm_expiration 240

_db_active_prewarm_interval 60

_db_active_prewarm_spare1 0

_db_active_prewarm_spare2 0

_db_aging_cool_count 1

_db_aging_freeze_cr FALSE

_db_aging_hot_criteria 2

_db_aging_stay_count 0

_db_aging_touch_time 3

_db_always_check_system_ts TRUE

_db_block_adjcheck TRUE

_db_block_adjchk_level 0

_db_block_align_direct_read TRUE

_db_block_bad_write_check FALSE

_db_block_buffers 336960

_db_block_cache_history_lru FALSE

_db_block_cache_protect false

_db_block_cache_protect_internal 0

_db_block_check_for_debug FALSE

_db_block_check_objtyp TRUE

_db_block_chunkify_ncmbr FALSE

_db_block_corruption_recovery_threshold 30

_db_block_do_full_mbreads FALSE

_db_block_hash_buckets 1048576

_db_block_hash_latches 8192

_db_block_header_guard_level 0

_db_block_hi_priority_batch_size 0

_db_block_iterations_for_rm 2000

_db_block_known_clean_pct 2

_db_block_lru_latches 36

_db_block_max_cr_dba 6

_db_block_max_scan_pct 40

_db_block_med_priority_batch_size 0

_db_block_numa 1

_db_block_prefetch_fast_longjumps_enabled TRUE

_db_block_prefetch_limit 0

_db_block_prefetch_override 0

_db_block_prefetch_private_cache_enabled TRUE

_db_block_prefetch_quota 10